Apache spark: una herramienta revolucionaria para la analítica de big data y el aprendizaje automático

En un mundo donde los datos son el nuevo petróleo, procesar y entender vastas cantidades de información es una piedra angular del avance tecnológico. Apache Spark ha emergido como una de las herramientas más robustas y poderosas para manejar big data de manera eficiente. Este motor de análisis de datos de código abierto ha revolucionado la forma en que las organizaciones procesan y analizan enormes flujos de datos. Profundicemos en los conceptos de Apache Spark, exploremos su historia, lo comparemos con otras tecnologías y entendamos cómo maneja tareas complejas de datos como un profesional.

¿Qué es apache spark?

Apache Spark es un motor de análisis de datos de vanguardia.

Apache Spark es un motor de análisis de datos de código abierto diseñado para procesar flujos masivos de datos de múltiples fuentes en tiempo real o en modo por lotes. La capacidad de Spark para realizar cálculos tan complejos se asemeja a algo como “un pulpo malabareando motosierras”. Se especializa en el procesamiento de datos distribuidos y logra una velocidad superior al realizar cálculos en memoria, lo que lo hace hasta 100 veces más rápido que los sistemas tradicionales basados en disco.

Los orígenes de apache spark

Apache Spark fue creado en el AMP Lab de UC Berkeley.

Apache Spark se originó en 2009, gracias a Matei Zaharia en el AMP Lab de UC Berkeley. Durante este tiempo, la generación de datos en internet estaba experimentando un crecimiento explosivo, pasando de megabytes a petabytes. Se volvió casi imposible realizar análisis sobre este volumen de datos utilizando máquinas tradicionales. Esta creciente necesidad dio origen al desarrollo de Apache Spark, proporcionando a investigadores y empresas una herramienta para procesar conjuntos de datos masivos a través de sistemas distribuidos.

Apache spark vs hadoop: la batalla de las herramientas de big data

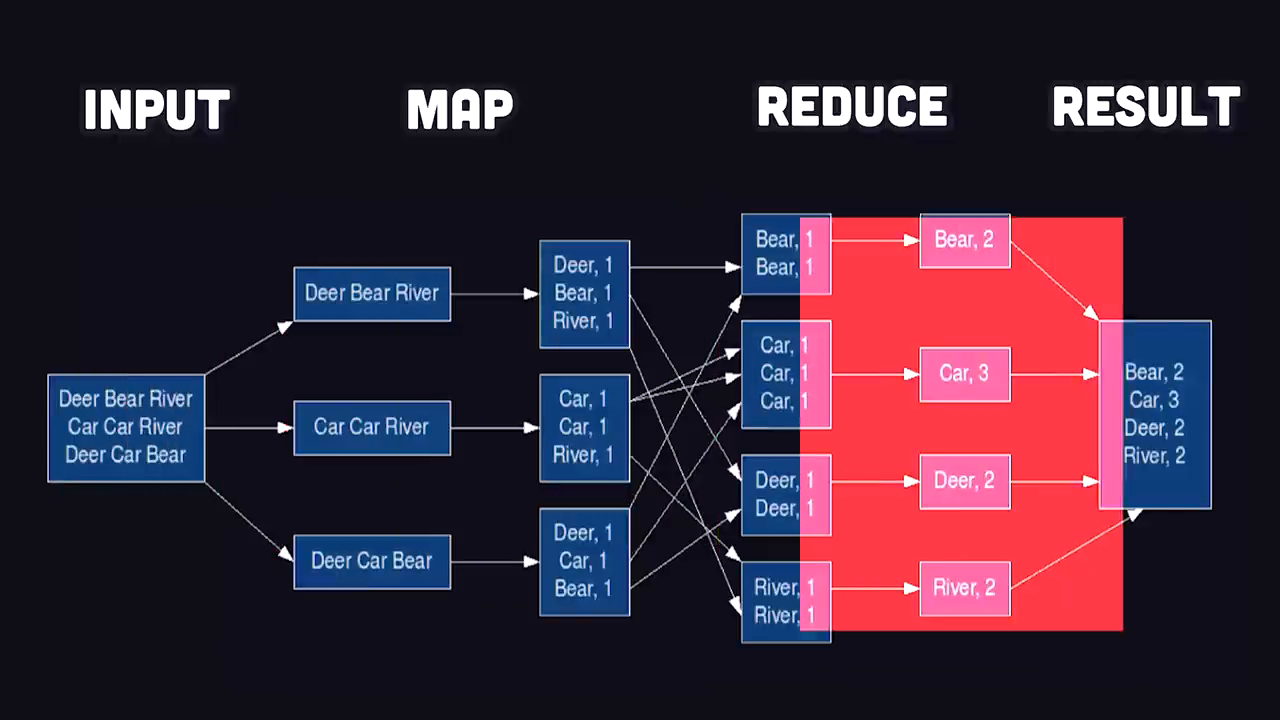

Apache Spark introdujo el procesamiento de datos en memoria en comparación con los flujos de trabajo basados en discos de Hadoop.

Antes de Apache Spark, MapReduce de Hadoop era el jugador dominante en la analítica de big data. MapReduce emplea un modelo de programación donde los datos se mapean en pares clave-valor, se mezclan, ordenan y reducen a resultados finales. Si bien es eficiente en el manejo de conjuntos de datos distribuidos, MapReduce enfrentaba cuellos de botella debido a su dependencia de operaciones de entrada/salida (E/S) basadas en disco.

Apache Spark cambió las reglas del juego al introducir un enfoque de procesamiento de datos en memoria. En lugar de leer y escribir resultados intermedios en disco, Spark procesa datos en RAM, acelerando significativamente el cálculo. Esta innovación eliminó el cuello de botella de E/S, haciendo que Spark sea hasta 100 veces más rápido que sus competidores.

Casos de uso en el mundo real de apache spark

Apache Spark potencia la analítica de datos para las empresas Fortune 500, NASA y más.

Apache Spark potencia algunas de las organizaciones más grandes del mundo en diversas industrias:

- Amazon: Spark ayuda a analizar datos de comercio electrónico, transformando la experiencia del cliente con recomendaciones y predicciones personalizadas.

- Laboratorio de Propulsión a Chorro de la NASA: Utiliza Spark para procesar enormes cantidades de datos espaciales, explorando las profundidades del universo.

- 80% de las empresas Fortune 500: Spark se ha convertido en la solución preferida para empresas que manejan complejas canalizaciones de big data y necesidades analíticas.

A pesar de su reputación como herramienta de computación distribuida, Spark también puede ejecutarse localmente, lo que lo hace accesible para proyectos a pequeña escala y desarrolladores individuales.

Cómo funciona apache spark

Comenzando con apache spark

Apache Spark permite el procesamiento local y distribuido a través de APIs fáciles.

Apache Spark está principalmente escrito en Java y se ejecuta en la Máquina Virtual de Java (JVM). Sin embargo, sus APIs admiten múltiples lenguajes como Python (a través de PySpark), SQL y Scala, lo que hace que Spark sea accesible para una amplia base de desarrolladores. Para comenzar, necesitas instalar Spark e iniciar una sesión.

Resolviendo problemas del mundo real con spark

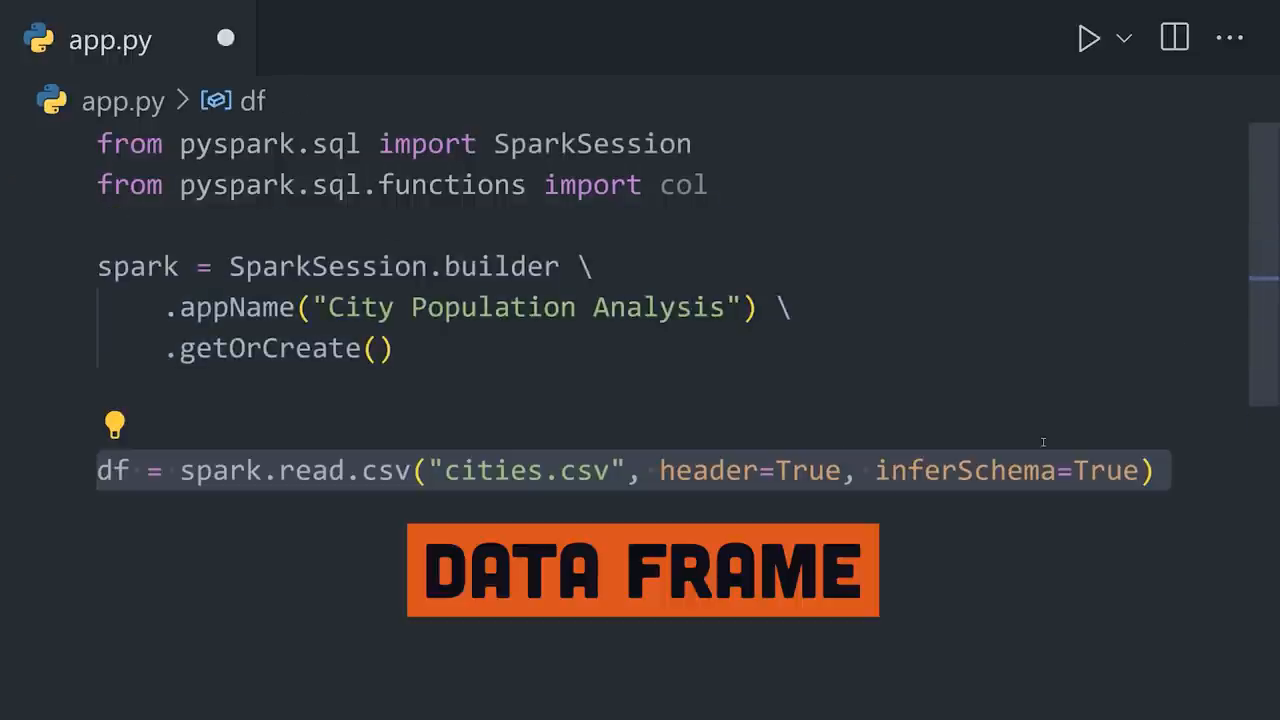

La API de DataFrame de Spark permite un filtrado intuitivo de datos del mundo real.

Imagina que tienes un archivo CSV con datos sobre ciudades, incluyendo población, latitud y longitud. Tu tarea es encontrar la ciudad más poblada ubicada entre los trópicos. Así es como Spark maneja este proceso paso a paso:

- Cargar los datos en memoria: Spark lee el archivo CSV y lo almacena como un DataFrame, transformando filas y columnas en objetos que pueden ser procesados en memoria a través de sistemas distribuidos.

- Filtrar los datos: Excluir ciudades fuera de los trópicos utilizando las poderosas funciones de transformación de Spark.

- Ordenar y seleccionar resultados: Ordenar los resultados filtrados por población y recuperar la ciudad con la mayor población. Spark hace que todo este proceso sea fluido a través de la encadenación de métodos con su API de DataFrame.

En este ejemplo, Spark identifica a la Ciudad de México como la ciudad con la mayor población tropical.

Spark con sql y clusters distribuidos

Spark se integra con bases de datos SQL y admite escalado por clusters.

Para aquellos que trabajan con bases de datos SQL, Spark proporciona una fácil integración para consultar datos directamente, mejorando su usabilidad para ingenieros de bases de datos. Además, al manejar conjuntos de datos masivos, el administrador de clusters de Spark o herramientas de orquestación de contenedores como Kubernetes pueden escalar cargas de trabajo horizontalmente a través de innumerables máquinas, logrando el procesamiento distribuido en su máxima expresión.

Apache spark para aprendizaje automático a gran escala

MLlib de Spark simplifica el aprendizaje automático a gran escala.

Apache Spark también brilla en el aprendizaje automático a través de su poderosa biblioteca conocida como MLlib. Al distribuir datos a través de clusters, Spark construye canalizaciones de aprendizaje automático escalables sin esfuerzo. Por ejemplo:

- ** ensamblador de vectores:** MLlib permite a los desarrolladores combinar múltiples columnas en una única columna vectorial.

- División de datos: Separar datos en conjuntos de entrenamiento y prueba para modelos de aprendizaje automático.

- Selección de algoritmos: MLlib admite algoritmos para clasificación, regresión, agrupamiento y más.

Este entrenamiento distribuido asegura que los modelos puedan aprovechar las capacidades de manejo de datos a gran escala de Spark para hacer predicciones precisas.

Educación y herramientas para comenzar con spark

Las habilidades en programación y análisis pueden desbloquear todo el potencial de Spark.

Si bien Spark es una herramienta robusta, aprovechar todo su potencial requiere una sólida base en programación, análisis de datos y estrategias de resolución de problemas. Plataformas como Brilliant.org pueden ayudar a las personas a construir estas habilidades críticas a través de lecciones inmersivas y ejercicios prácticos. Invertir tiempo en mejorar el pensamiento lógico y los hábitos de programación puede mejorar significativamente tu competencia con herramientas como Apache Spark.

Conclusión

Apache Spark desbloquea el potencial de la analítica de big data escalable.

Apache Spark continúa transformando la analítica de big data con su computación en memoria, escalabilidad e integración con tecnologías de aprendizaje automático. Se ha convertido en un pilar para campos que van desde la academia y la investigación hasta las empresas industriales. Ya sea que estés analizando tendencias de comercio electrónico, procesando datos de espacios profundos o entrenando modelos de aprendizaje automático a escala, Spark ofrece un rendimiento y eficiencia inigualables.

A medida que nos apoyamos en herramientas revolucionarias como Apache Spark, es esencial seguir aprendiendo y desarrollando nuestras habilidades para adaptarnos al panorama tecnológico en constante cambio. Entonces, ¿por qué no dar el primer paso hacia el mundo de Spark y big data hoy?