Automatización de la investigación en Internet con Apify y n8n

Este artículo explora un sistema para automatizar la investigación en Internet utilizando Apify y n8n, demostrando cómo raspar datos, hacer llamadas a APIs y generar informes entregados directamente a tu canal de Slack. Esta automatización se puede aplicar a diversas tareas como recopilar noticias diarias, actualizaciones de competidores y generación de leads, ahorrando un tiempo y esfuerzo significativos.

Introducción: La necesidad de investigación automatizada

Mantenerse informado sobre las últimas noticias y tendencias de Inteligencia Artificial

Mantenerse informado sobre las últimas noticias y tendencias de Inteligencia Artificial

Como empresa de desarrollo de Inteligencia Artificial, mantenerse informado sobre las últimas tecnologías, tendencias y noticias es crucial. Esto requiere una investigación constante, que puede ser tediosa. El sistema descrito aquí automatiza el proceso de investigación, entregando un informe diario con información relevante directamente a un canal de Slack designado. Esto elimina la necesidad de buscar manualmente artículos, simplificando significativamente el flujo de trabajo de investigación.

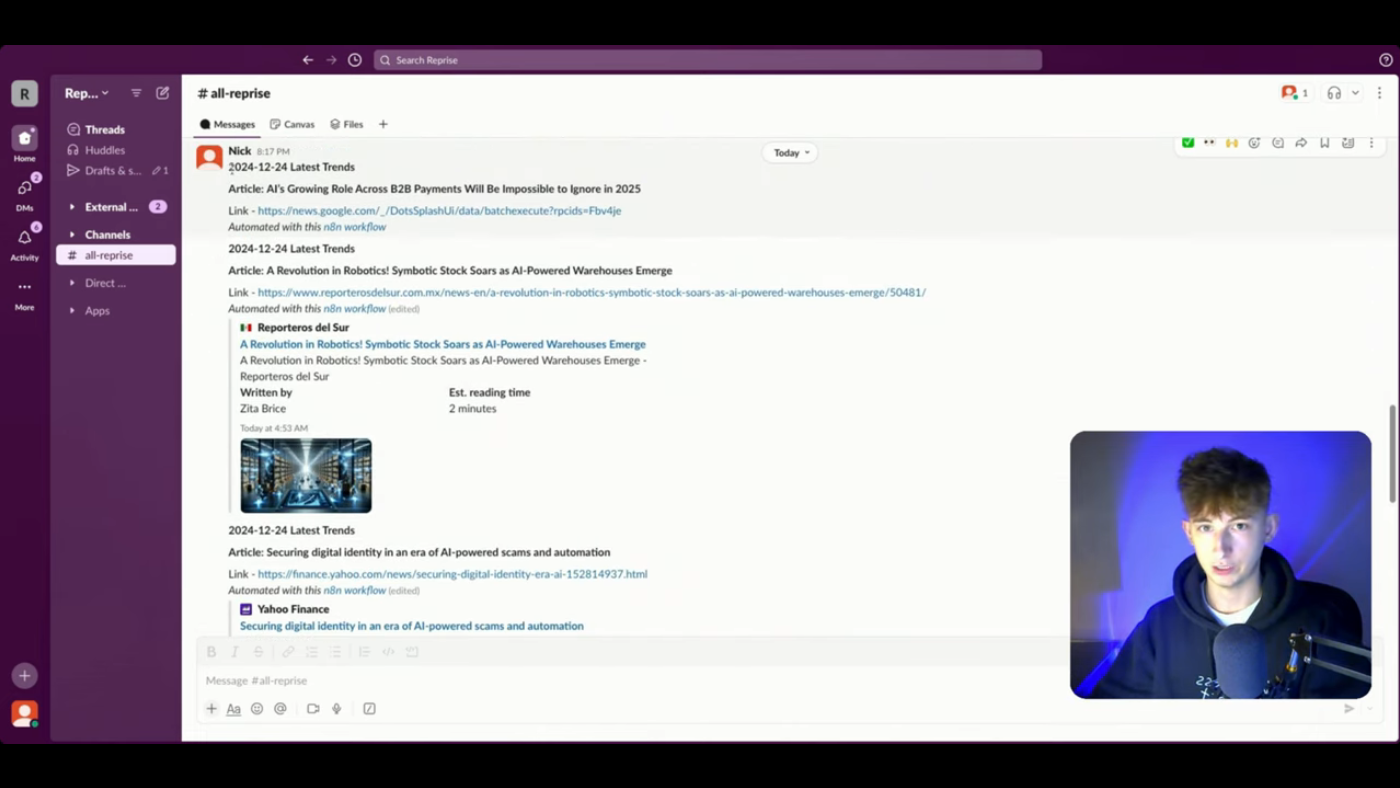

Demo: Entrega automática de noticias de Inteligencia Artificial a Slack

La demostración muestra un sistema que investiga automáticamente las últimas tendencias de Inteligencia Artificial cada mañana y entrega un informe a un canal de Slack. El informe contiene enlaces a artículos relevantes, eliminando un paso manual en el proceso de investigación.

Por ejemplo, el informe de Slack mostrado contiene artículos sobre "el creciente papel de la Inteligencia Artificial en los pagos B2B", "una revolución en la robótica" y "almacenes con tecnología de Inteligencia Artificial", todos con enlaces directos al material fuente. Esto demuestra cómo la automatización recopila artículos relevantes y los presenta en un formato fácil de digerir, listo para ser revisado. El sistema es flexible y se puede configurar para entregar informes vía correo electrónico o WhatsApp también. Más allá de solo enlazar artículos, el sistema se puede mejorar aún más para resumir la información recuperada, ofrecer un análisis más profundo utilizando plataformas como Perplexity o activar acciones específicas basadas en los datos encontrados.

Construyendo el flujo de trabajo: Raspar con Apify y n8n

Visualizando el flujo de trabajo en una pizarra

Visualizando el flujo de trabajo en una pizarra

Para ilustrar el proceso de construcción, una pizarra simplifica la visualización del flujo de trabajo. El sistema utiliza Apify, una plataforma de raspado web y automatización, y n8n, una herramienta de automatización de flujo de trabajo.

El proceso comienza identificando una tarea recurrente o datos frecuentemente buscados. En el ejemplo, la tarea recurrente del presentador es investigar tecnologías y tendencias emergentes en Inteligencia Artificial.

Primero, se determina qué debe automatizarse. Se proporcionan varios ejemplos departamentales:

- Investigación de competidores: Monitorear actualizaciones de competidores, cambios de precios y lanzamientos de productos.

- Investigación de mercado: Analizar reseñas de clientes para puntos dolorosos, rastrear precios de productos en sitios web de competidores y monitorear cambios en documentos de cumplimiento.

- Monitoreo de la industria: Raspar artículos sobre automatización de Inteligencia Artificial, rastrear temas candentes en Google News y monitorear las inversiones o financiamientos de la industria.

- Generación de leads: Raspar información de contacto de varias fuentes.

- Creación de contenido: Agregar información de varias fuentes para la creación de contenido.

A continuación, se identifica si Apify tiene "actores" (módulos o APIs) existentes aplicables a la tarea. Por ejemplo, raspar Google News para tendencias de automatización de Inteligencia Artificial podría utilizar el actor de raspado de Google News.

El flujo de trabajo en n8n comienza con un nodo "Cron", programando la automatización para ejecutarse diariamente a las 9:00 AM. Este nodo activa todo el proceso cada mañana.

Haciendo la llamada a la API: Conectando n8n a Apify

Configurando el nodo de solicitud HTTP en n8n

Configurando el nodo de solicitud HTTP en n8n

El sistema interactúa con Apify a través de solicitudes HTTP en n8n. Se utiliza un nodo "Solicitud HTTP" dedicado para este propósito.

Aquí hay un desglose detallado:

- Punto final de la API: El punto final de la API para el actor de Apify se ingresa en el campo URL del nodo de solicitud HTTP. Este punto final, junto con la clave de API necesaria, inicia el proceso de raspado de datos en Apify. Esta información se encuentra en la plataforma de Apify bajo API -> Puntos finales. Para este flujo de trabajo específico, el punto final es:

api.apify.com/v2/actor-runs. - Encabezados: El nodo de solicitud HTTP incluye encabezados para especificar el tipo de contenido. Para este flujo de trabajo, el

Content-Typese establece enapplication/json, lo que indica una estructura JSON para la comunicación entre n8n y Apify. - Cuerpo: El contenido del cuerpo para la llamada a la API se formatea en JSON, definiendo los parámetros de raspado para el actor de Apify elegido. Esto incluye detalles como la consulta de búsqueda ("Tecnologías emergentes de Inteligencia Artificial"), las fechas de inicio y fin para la búsqueda y las limitaciones de memoria (memoria asignada al actor en MB).

- Autenticación: La clave de API de Apify se incluye en los parámetros de encabezado o directamente dentro de la URL del punto final de la API dentro del nodo de solicitud HTTP para autenticar la llamada. Esta clave permite que n8n se comunique y ejecuta el raspador en Apify. La asignación de memoria (

&memory=1024) se agrega dentro de la URL.

Accediendo al sistema y utilizando los hallazgos

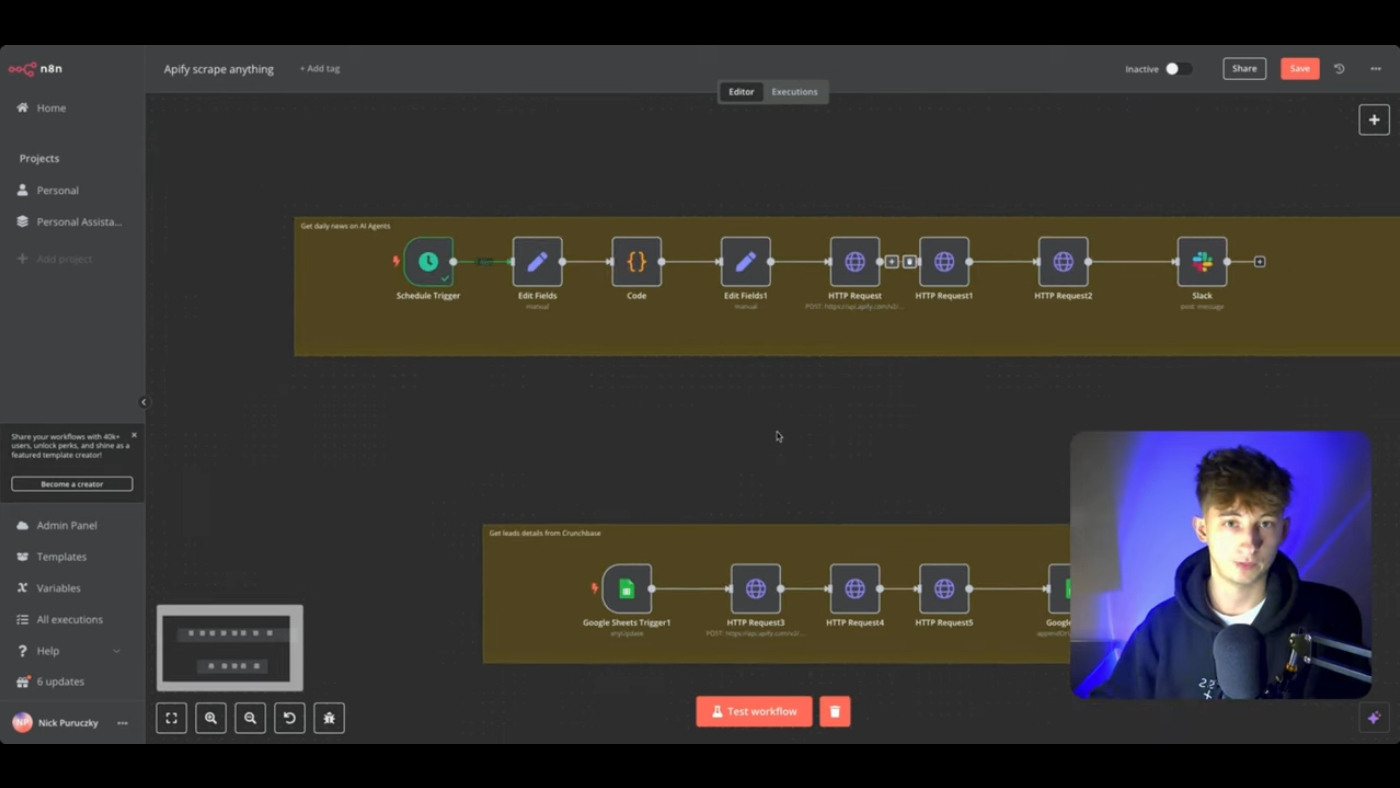

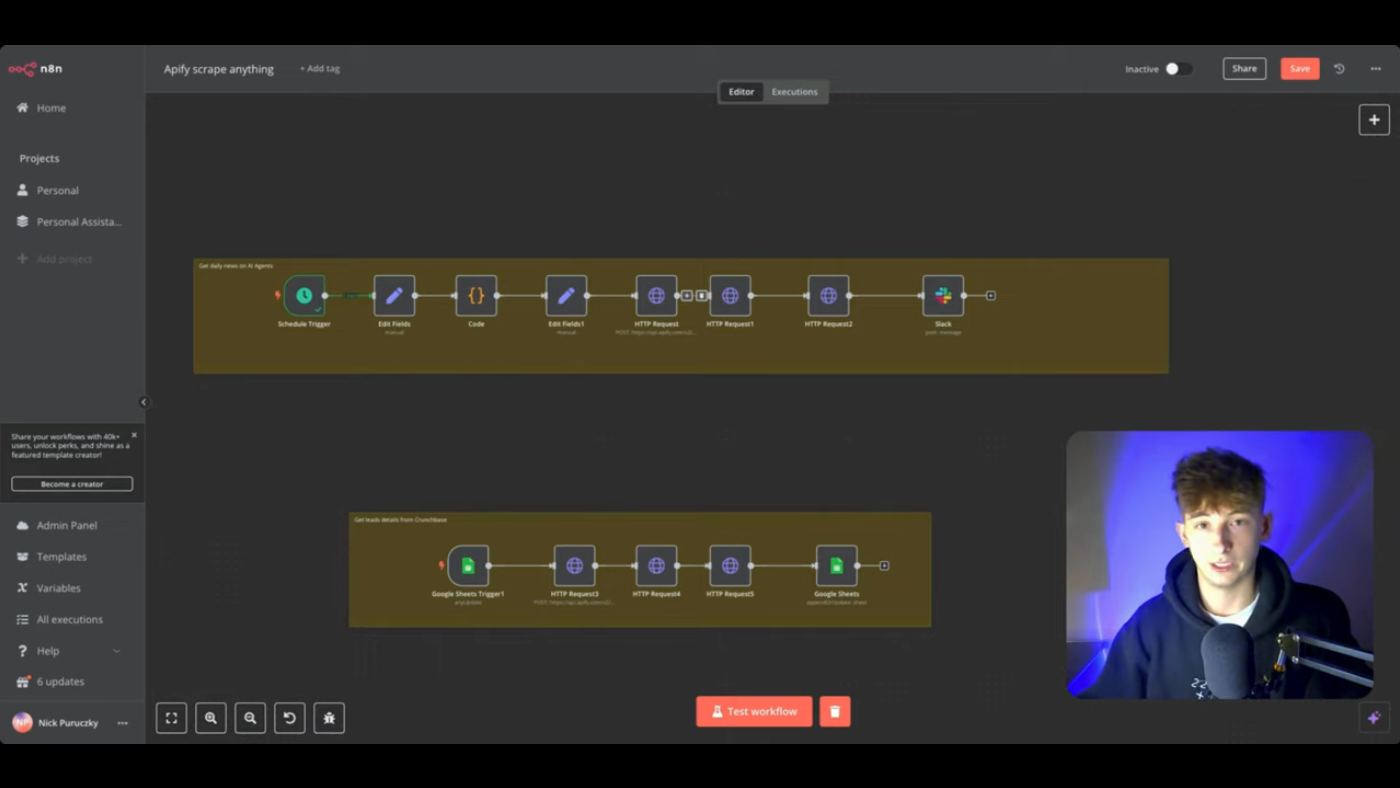

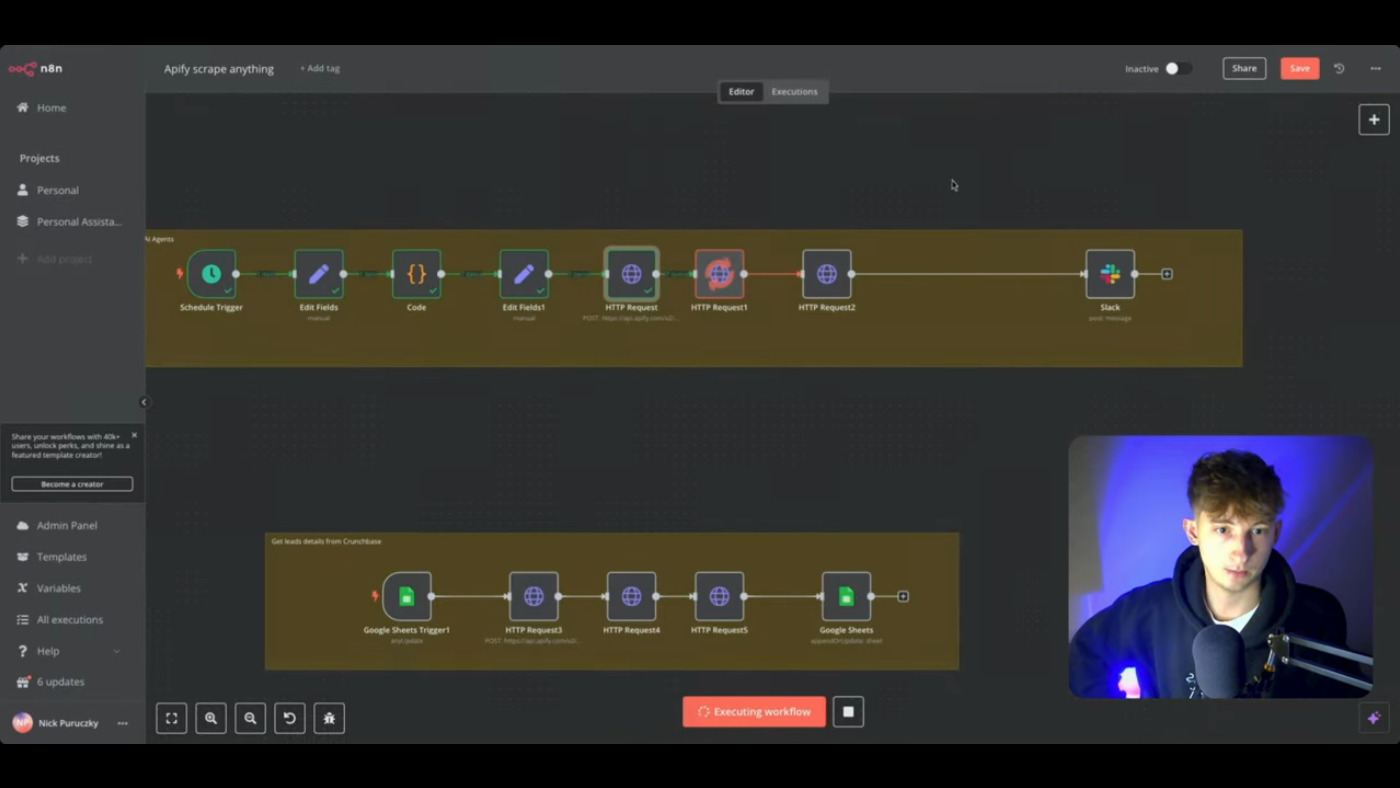

Flujo de trabajo de n8n completo

Flujo de trabajo de n8n completo

El flujo de trabajo de n8n completado se muestra, mostrando las conexiones y el orden de las tareas ejecutadas: nodo Cron, nodo de configuración, varios nodos de solicitud HTTP y un nodo de Slack. El sistema se puede personalizar aún más. Por ejemplo, después de recuperar los enlaces, se puede agregar un nodo para utilizar un servicio como Perplexity para resumir los artículos antes de publicarlos en un canal de Slack.

El acceso al flujo de trabajo completo, incluidas las instrucciones de configuración, está disponible dentro de una comunidad de pago enlazada en la descripción del video. El creador de contenido también invita a los propietarios de empresas que buscan soluciones personalizadas de Inteligencia Artificial a aplicar utilizando el enlace proporcionado en la descripción.

Constructores de este flujo de trabajo requiere tres solicitudes HTTP principales:

- Iniciar el actor de Apify: Esto recupera el ID de ejecución del actor, incluyendo configuraciones personalizadas como tema de búsqueda y parámetros de datos formateados en JSON.

- Recuperar el ID del conjunto de datos: El ID del conjunto de datos se obtiene en función del ID de ejecución de la etapa uno, lo que permite acceder a los datos raspados.

- Recuperar los datos y enviarlos a Slack: Finalmente, utilizando el ID del conjunto de datos de la etapa dos, se realiza una llamada a la API para recuperar todos los datos que se pueden analizar y enviar a Slack como informe diario.

Este enfoque modular permite adaptarse a otras tareas de raspado simplemente cambiando el actor de Apify y los parámetros asociados en el flujo de trabajo. El sistema también se puede expandir para enviar el informe a varias plataformas como correo electrónico, WhatsApp o Google Sheets, demostrando una aplicación práctica más amplia.