Implementación de un asistente de compartición de pantalla en tiempo real con voz y transcripción utilizando los modelos Gemini 2.0 y Gemini 1.5

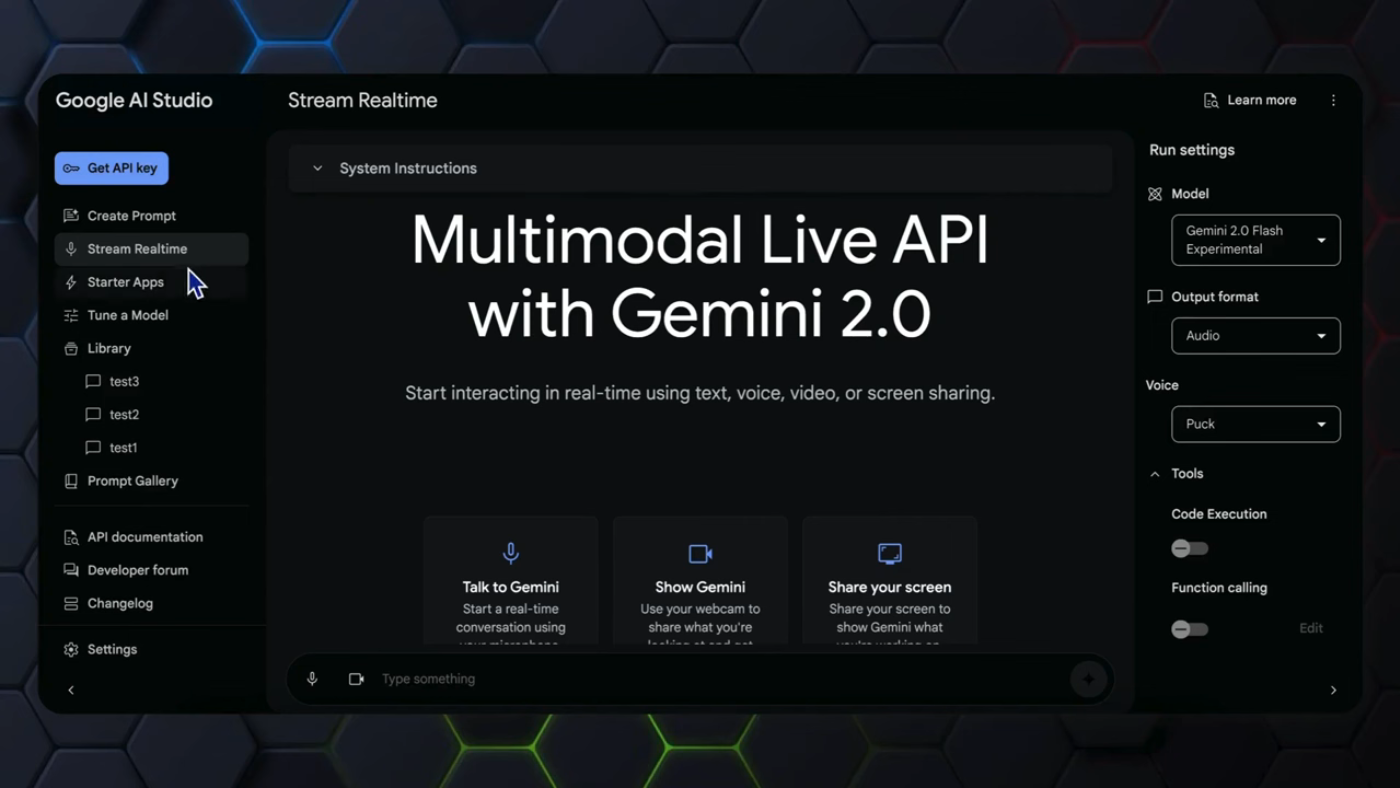

En este artículo, exploraremos cómo implementar un asistente de compartición de pantalla en tiempo real con voz y transcripción utilizando los modelos Gemini 2.0 y Gemini 1.5. La API de Gemini de varios modos en vivo ha sido utilizada en videos anteriores para demostrar sus capacidades, incluyendo interacciones en tiempo real a través de texto, voz y cámara, junto con la compartición de pantalla.

Introducción a la API de Gemini de varios modos en vivo

La API de Gemini de varios modos en vivo es una herramienta poderosa que permite interacciones en tiempo real a través de texto, voz y cámara, junto con la compartición de pantalla. Sin embargo, aún existe un problema crítico que impide la implementación de aplicaciones en el mundo real, que es la incapacidad de proporcionar respuestas de texto y audio en tiempo real.  Introducción a la API de Gemini de varios modos en vivo

Introducción a la API de Gemini de varios modos en vivo

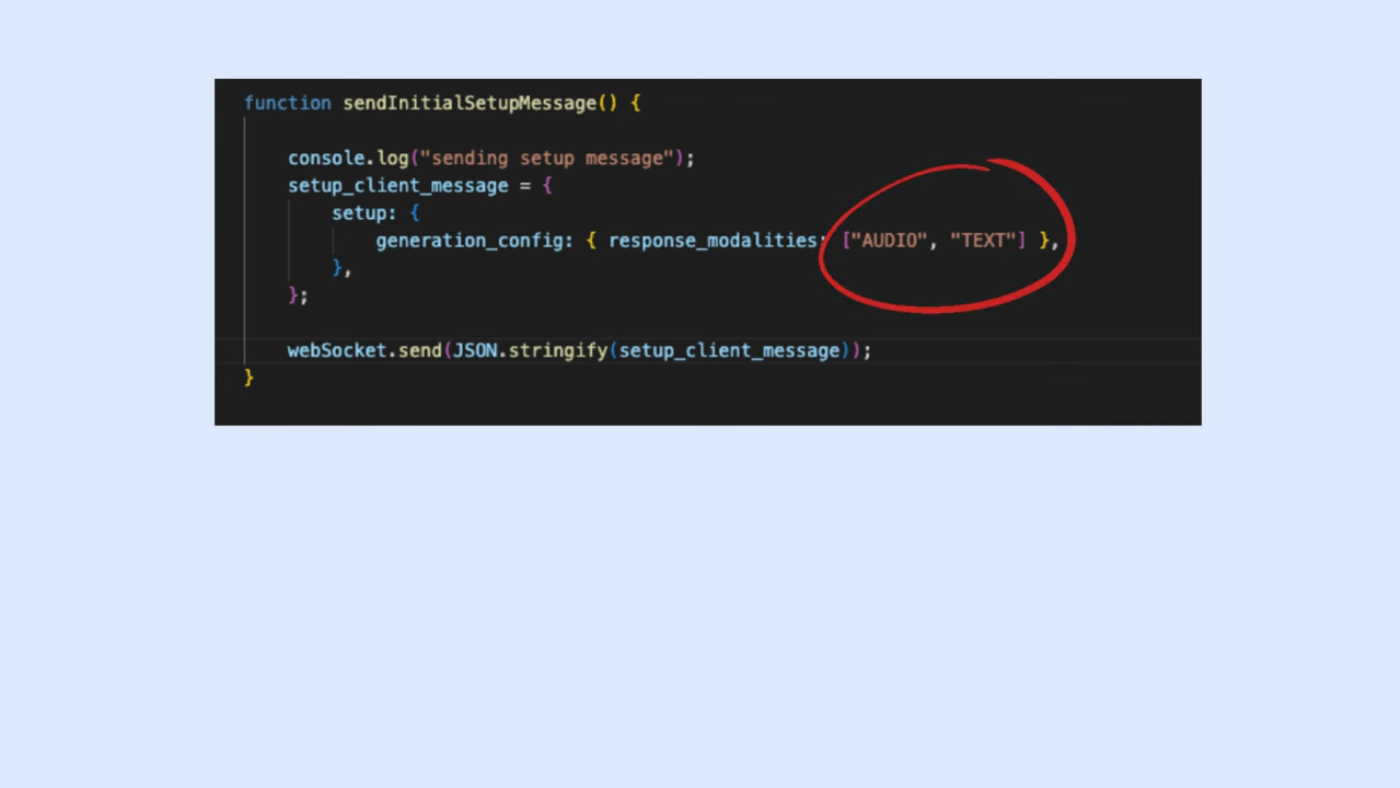

Problema persistente de la API de Gemini

El parámetro "response_modality" en la biblioteca se permite establecer como una lista de "audio" más "texto", pero esta configuración no funciona como se espera, con solo un error en todo momento.  Problema persistente de la API de Gemini

Problema persistente de la API de Gemini

Arquitectura del proyecto

La aplicación utiliza dos modelos Gemini en un proceso fluido. Primero, el cliente envía entradas visuales y de audio al servidor. Luego, el servidor utiliza el modelo Gemini 2.0 Flash para la generación de streaming de audio en tiempo real. A continuación, el servidor utiliza esa salida para transcribir la salida de audio en texto utilizando el modelo Gemini 1.5 Flash 8B.  Arquitectura del proyecto

Arquitectura del proyecto

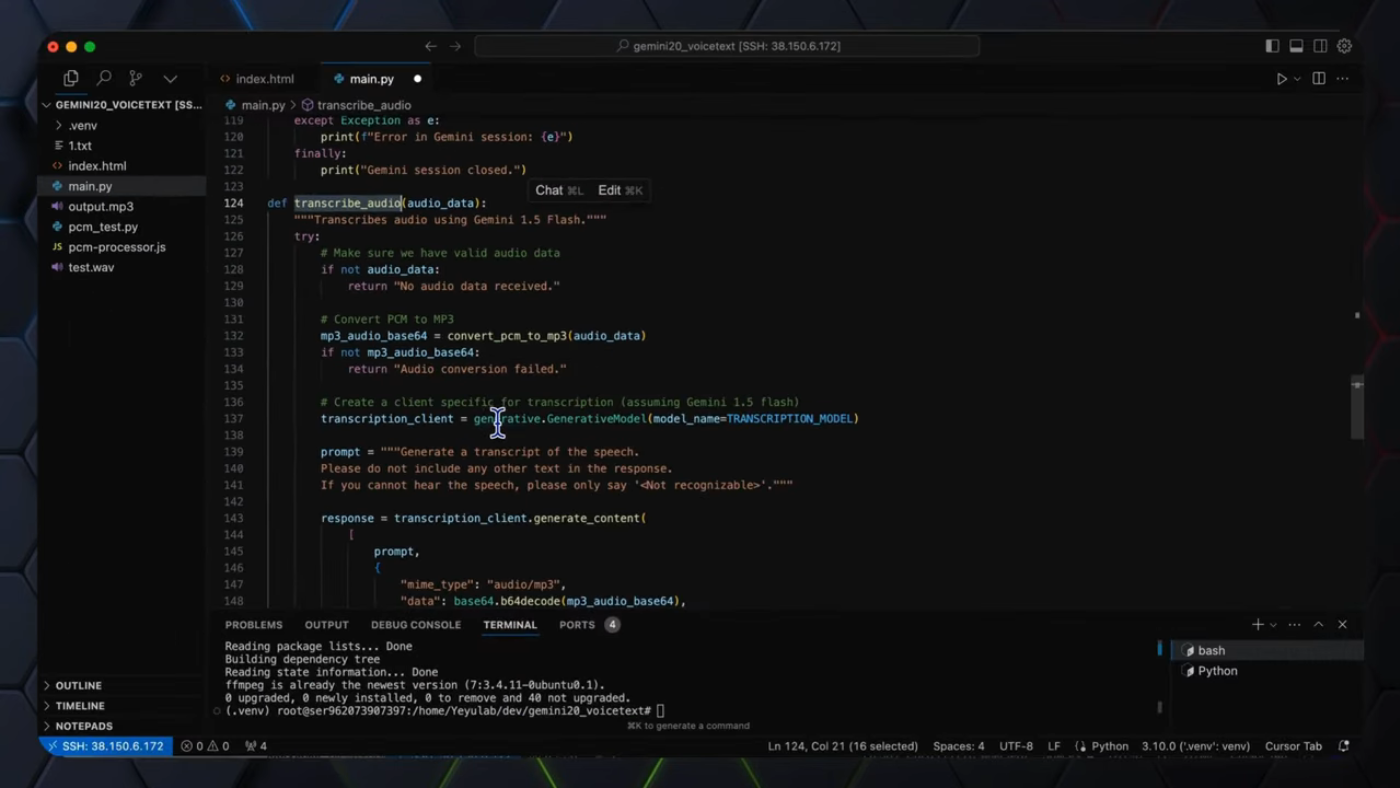

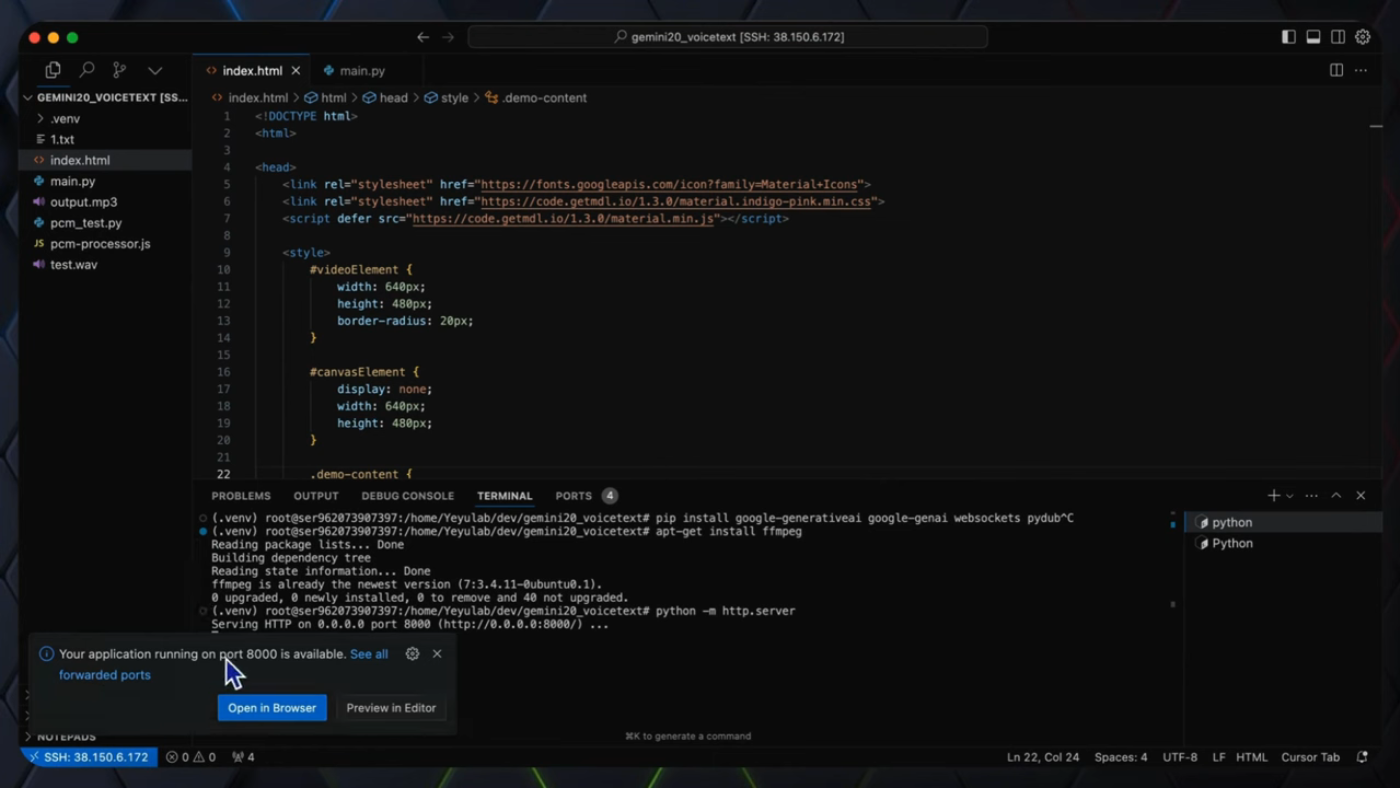

Recorrido del código

El código del servidor es responsable de manejar el mensaje de configuración del cliente, conectarse a la API de Gemini 2.0 de varios modos en vivo y enviar y recibir datos. La función "gemini_session_handler" se utiliza para manejar la conexión de WebSocket y el intercambio de datos con la API de Gemini 2.0 de varios modos en vivo.  Recorrido del código

Recorrido del código

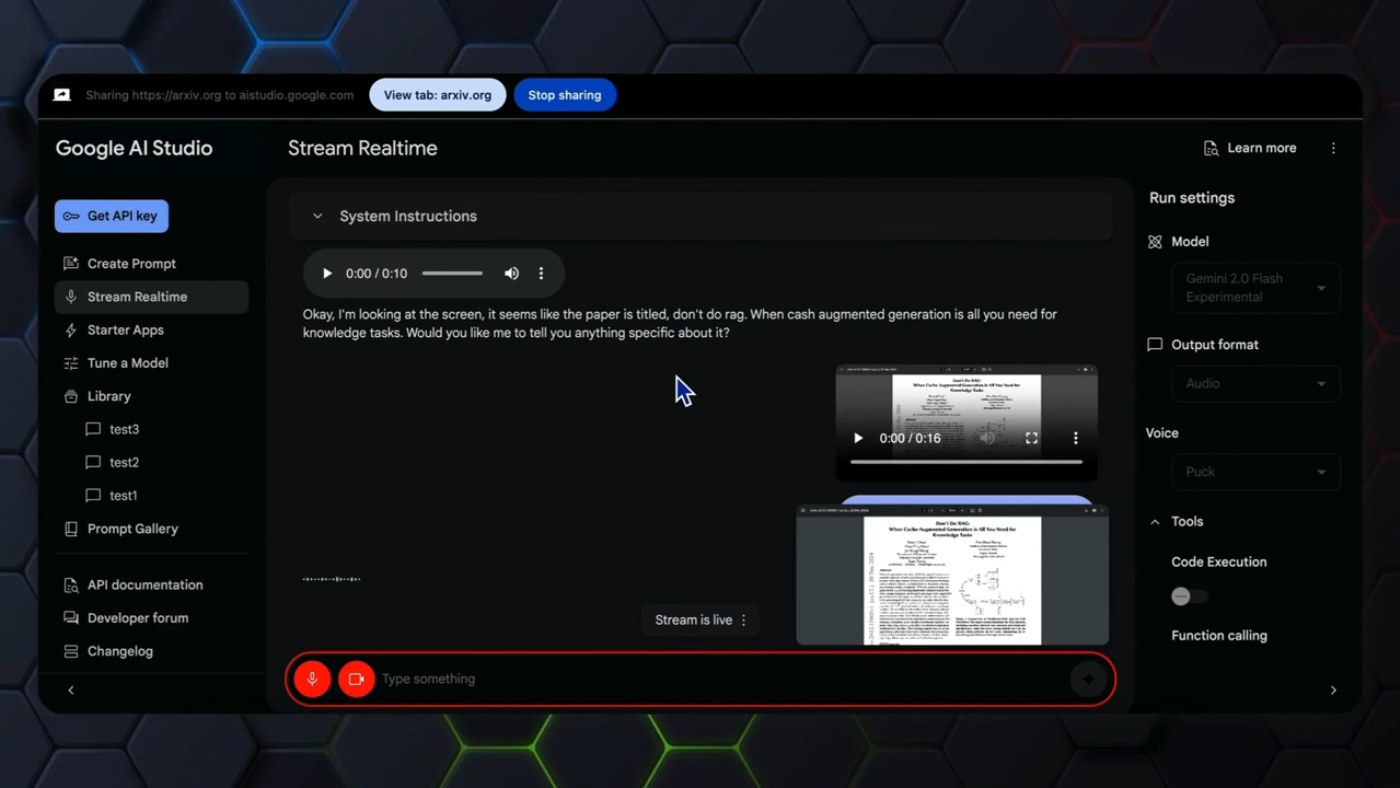

Ejecutar la aplicación

El proceso completo de compartición de pantalla se implementa con la API de Gemini 2.0 de varios modos en vivo en el video anterior. Las funciones clave de mejora de texto y audio están en el servidor backend, y el código frontend se puede copiar del repositorio de GitHub.  Ejecutar la aplicación

Ejecutar la aplicación

Conclusión

En conclusión, este video aborda la limitación de la API de Gemini de varios modos en vivo al proporcionar tanto transcripciones legibles como retroalimentación de audio para implementar el asistente de compartición de pantalla en tiempo real. La aplicación utiliza dos modelos Gemini en un proceso fluido, y el código del servidor es responsable de manejar el mensaje de configuración del cliente, conectarse a la API de Gemini 2.0 de varios modos en vivo y enviar y recibir datos.  Conclusión

Conclusión

Desarrollo futuro

La API de Gemini de varios modos en vivo aún se encuentra en su etapa inicial, y existen muchas oportunidades para el desarrollo futuro. El uso de dos modelos diferentes, Gemini 2.0 Flash y Gemini 1.5 Flash 8B, proporciona una solución eficiente y rentable para la generación de streaming de audio en tiempo real y la transcripción.  Desarrollo futuro

Desarrollo futuro