Introducción a Ollama: Una herramienta de código abierto gratuita para administrar y ejecutar LLMs de forma local

En este artículo, exploraremos Ollama, una herramienta de código abierto fantástica y gratuita que permite administrar y ejecutar Modelos de Lenguaje Grande (LLMs) de forma local, proporcionando privacidad, seguridad y lo mejor de todo, es completamente gratuita.

Visión general de Ollama

Introducción a Ollama, una herramienta de código abierto gratuita para administrar y ejecutar LLMs de forma local

Ollama es una herramienta de código abierto gratuita que permite administrar y ejecutar LLMs de forma local, proporcionando una alternativa a los servicios alojados que requieren pago. Con Ollama, puedes ejecutar modelos de forma local en tu propio ordenador, dándote privacidad, seguridad y lo mejor de todo, es completamente gratuita.

Introducción a Ollama, una herramienta de código abierto gratuita para administrar y ejecutar LLMs de forma local

Ollama es una herramienta de código abierto gratuita que permite administrar y ejecutar LLMs de forma local, proporcionando una alternativa a los servicios alojados que requieren pago. Con Ollama, puedes ejecutar modelos de forma local en tu propio ordenador, dándote privacidad, seguridad y lo mejor de todo, es completamente gratuita.

Instalación de Ollama

Instalación de Ollama, una guía paso a paso

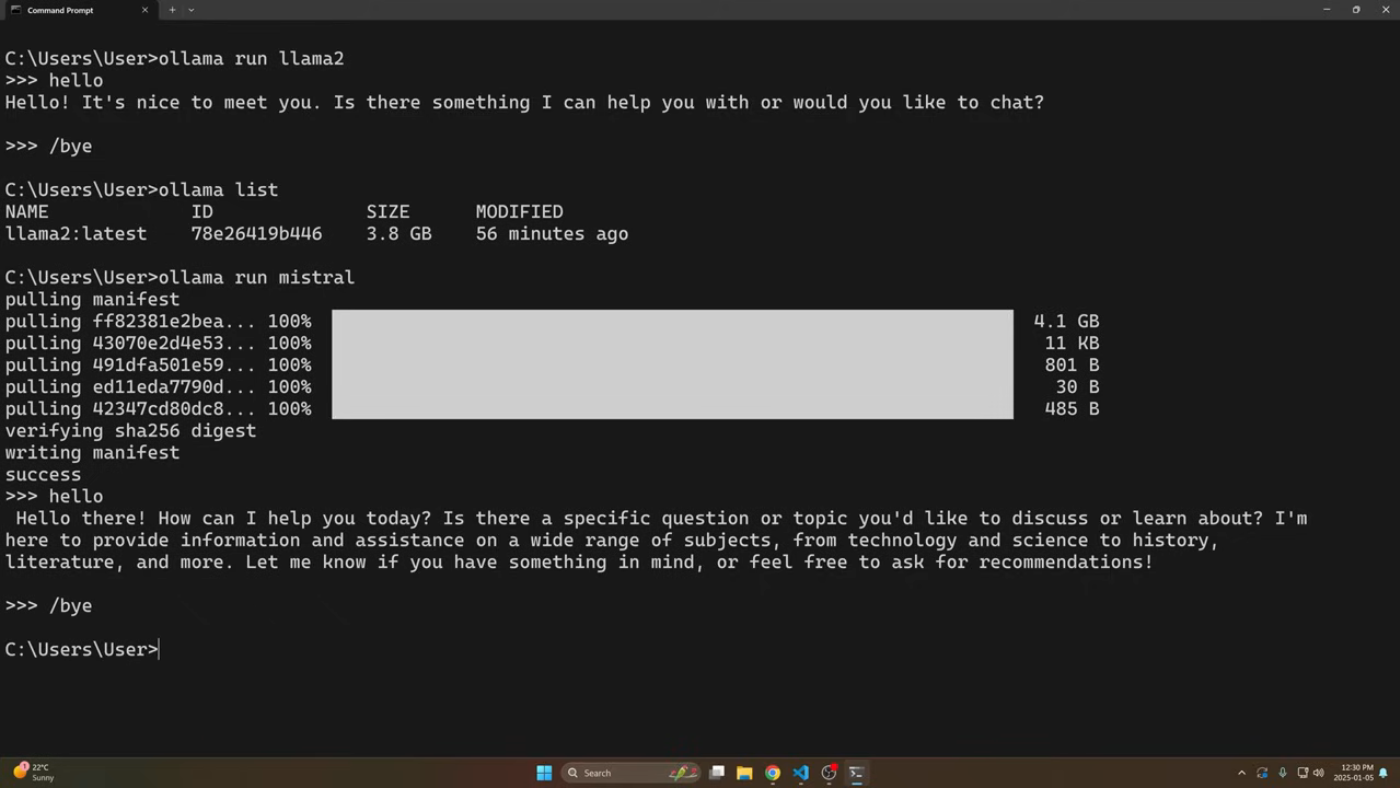

Para empezar a usar Ollama, debes instalarla en tu ordenador. El proceso de instalación es sencillo y, una vez instalado, puedes comenzar a administrar y ejecutar LLMs de forma local.

Instalación de Ollama, una guía paso a paso

Para empezar a usar Ollama, debes instalarla en tu ordenador. El proceso de instalación es sencillo y, una vez instalado, puedes comenzar a administrar y ejecutar LLMs de forma local.

Ejecución de modelos de forma local

Ejecución de modelos de forma local con Ollama

Con Ollama, puedes ejecutar modelos de forma local en tu propio ordenador, dándote más control y flexibilidad. Puedes ejecutar varios modelos, y Ollama proporciona una interfaz sencilla e intuitiva para administrarlos.

Ejecución de modelos de forma local con Ollama

Con Ollama, puedes ejecutar modelos de forma local en tu propio ordenador, dándote más control y flexibilidad. Puedes ejecutar varios modelos, y Ollama proporciona una interfaz sencilla e intuitiva para administrarlos.

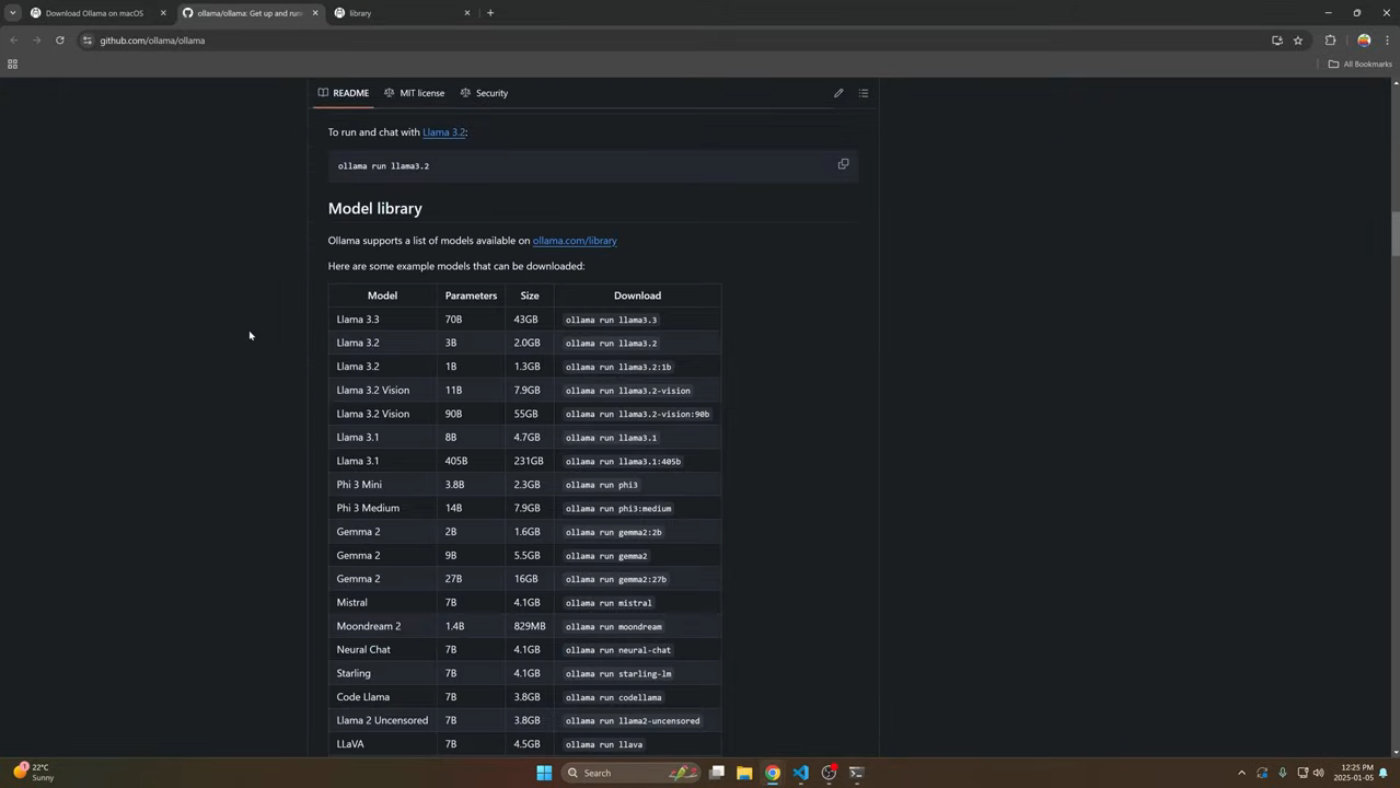

Adición de múltiples modelos

Adición de múltiples modelos con Ollama

Ollama permite agregar múltiples modelos, lo que facilita la administración y ejecución de diferentes modelos de forma local. Puedes agregar modelos con diferentes parámetros y configuraciones, dándote más flexibilidad y control.

Adición de múltiples modelos con Ollama

Ollama permite agregar múltiples modelos, lo que facilita la administración y ejecución de diferentes modelos de forma local. Puedes agregar modelos con diferentes parámetros y configuraciones, dándote más flexibilidad y control.

Servidor HTTP/API de Ollama

Servidor HTTP/API de Ollama, una herramienta poderosa para administrar modelos

Ollama proporciona un servidor HTTP/API que permite administrar modelos de forma remota. Puedes usar la API para agregar, eliminar y administrar modelos, lo que facilita la automatización de tareas y la integración con otras herramientas.

Servidor HTTP/API de Ollama, una herramienta poderosa para administrar modelos

Ollama proporciona un servidor HTTP/API que permite administrar modelos de forma remota. Puedes usar la API para agregar, eliminar y administrar modelos, lo que facilita la automatización de tareas y la integración con otras herramientas.

Llamada a la API HTTP (Código)

Llamada a la API HTTP con código, una guía paso a paso

Puedes llamar a la API HTTP de Ollama utilizando código, lo que facilita la automatización de tareas y la integración con otras herramientas. La API proporciona una interfaz sencilla e intuitiva para administrar modelos, y puedes usarla para agregar, eliminar y administrar modelos.

Llamada a la API HTTP con código, una guía paso a paso

Puedes llamar a la API HTTP de Ollama utilizando código, lo que facilita la automatización de tareas y la integración con otras herramientas. La API proporciona una interfaz sencilla e intuitiva para administrar modelos, y puedes usarla para agregar, eliminar y administrar modelos.

Paquete Python de Ollama

Paquete Python de Ollama, una herramienta poderosa para administrar modelos

Ollama proporciona un paquete Python que permite administrar modelos utilizando código Python. Puedes usar el paquete para agregar, eliminar y administrar modelos, lo que facilita la automatización de tareas y la integración con otras herramientas.

Paquete Python de Ollama, una herramienta poderosa para administrar modelos

Ollama proporciona un paquete Python que permite administrar modelos utilizando código Python. Puedes usar el paquete para agregar, eliminar y administrar modelos, lo que facilita la automatización de tareas y la integración con otras herramientas.

Personalización de modelos

Personalización de modelos con Ollama, una guía paso a paso

Puedes personalizar modelos con Ollama, lo que facilita la personalización de parámetros y configuraciones. Puedes usar los archivos de modelo para personalizar modelos y, luego, crearlos en Ollama.

Personalización de modelos con Ollama, una guía paso a paso

Puedes personalizar modelos con Ollama, lo que facilita la personalización de parámetros y configuraciones. Puedes usar los archivos de modelo para personalizar modelos y, luego, crearlos en Ollama.

Conclusión

En conclusión, Ollama es una herramienta poderosa para administrar y ejecutar LLMs de forma local. Proporciona una interfaz sencilla e intuitiva para administrar modelos, y puedes usarla para agregar, eliminar y administrar modelos. Ollama es completamente gratuita, lo que te da privacidad, seguridad y flexibilidad. Con Ollama, puedes ejecutar modelos de forma local en tu propio ordenador, lo que facilita la automatización de tareas y la integración con otras herramientas.