La aurora del ajuste fino por refuerzo: desbloqueando la próxima frontera en la versatilidad de la IA

El ajuste fino por refuerzo (RFT) se presenta como uno de los avances más significativos en la personalización de modelos de IA. Recientemente exhibido en una presentación de OpenAI, este enfoque de vanguardia promete revolucionar la forma en que los desarrolladores, investigadores y empresas optimizan sus modelos de IA para tareas específicas. Liderada por el equipo de OpenAI, la presentación reveló el poder de combinar técnicas de aprendizaje por refuerzo con ajuste fino personalizable, un salto que promete hacer que modelos de IA de frontera como GPT-4 y la serie O1 sean más adaptables que nunca.

Este artículo explora los conocimientos del transcript de la presentación, investigando el porqué, qué y cómo del ajuste fino por refuerzo, junto con sus aplicaciones prácticas.

La nueva innovación de OpenAI: O1 y ajuste fino por refuerzo

OpenAI presenta el ajuste fino por refuerzo con los modelos personalizables de la serie O1

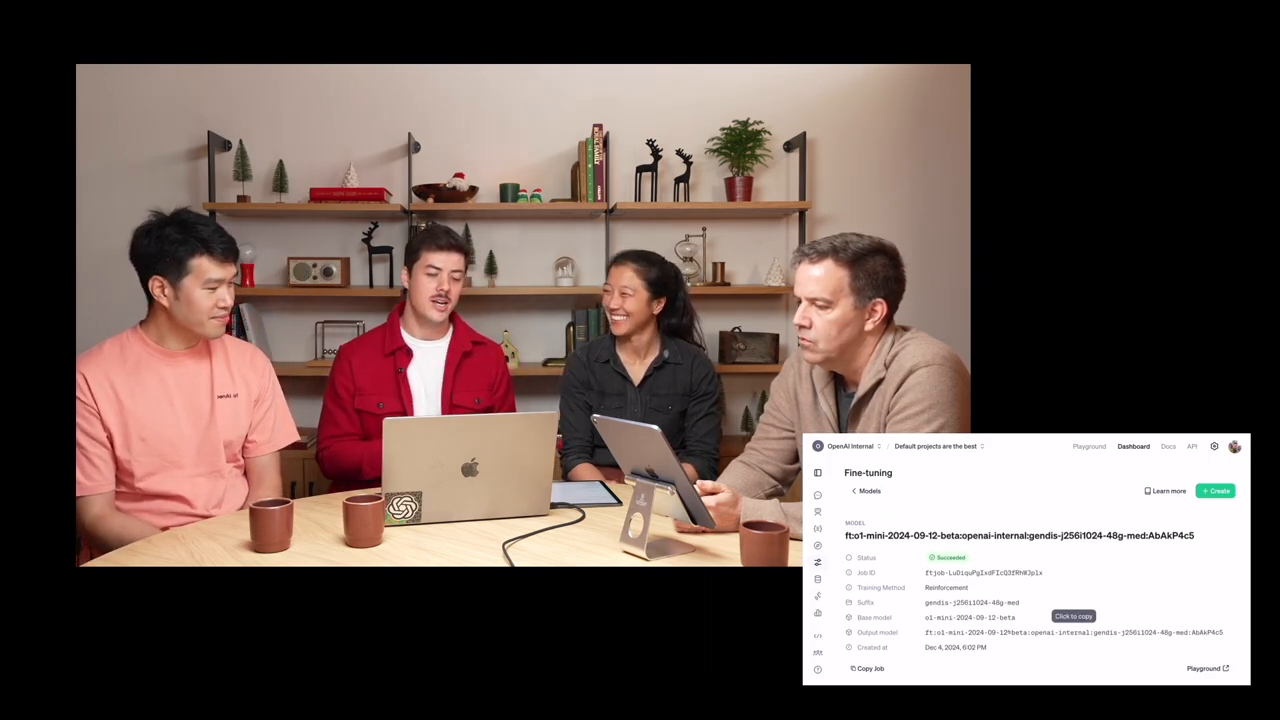

Mark, un investigador principal en OpenAI, comenzó la sesión presentando su nueva serie de modelos, O1. Recientemente lanzada, la serie O1 de modelos presume de un salto sustancial en cómo abordan la resolución de problemas; los modelos "piensan" por un tiempo antes de generar una respuesta, lo que representa un proceso de toma de decisiones más matizado.

El ajuste fino por refuerzo se basa en esa innovación al permitir que desarrolladores y organizaciones adapten los modelos O1 utilizando sus conjuntos de datos personalizados—no a través del ajuste fino tradicional, sino con principios de aprendizaje por refuerzo.

Este avance no se trata simplemente de imitar entradas existentes; en cambio, permite a los modelos razonar de manera más sistemática. Al darle a los modelos "espacio para pensar," como explicó Mark, este enfoque optimiza las tuberías de razonamiento, mejora la generalización y empodera a los usuarios para crear modelos de expertos específicos de dominio.

Por qué el ajuste fino por refuerzo es importante

La capacidad de ajustar modelos de IA tiene un inmenso potencial, particularmente para organizaciones que manejan datos especializados. El ajuste fino por refuerzo se distingue al permitir el desarrollo de herramientas de IA que van más allá de hacer coincidir patrones; permite el razonamiento lógico sobre los datos. OpenAI destacó varios campos clave donde su proceso de ajuste fino por refuerzo O1 ofrece casos de uso transformadores:

- Legal y financiero: Desarrollo de herramientas específicas de dominio para industrias que dependen de análisis impulsados por la lógica.

- Ingeniería y seguros: Razonamiento específico para tareas optimizado para procesos de pensamiento estructurados y sistemáticos.

- Salud y biología: Apoyo a investigadores en áreas como análisis genético y desarrollo de medicamentos.

Por ejemplo, la reciente asociación de OpenAI con Thomson Reuters utilizó el ajuste fino por refuerzo para mejorar Co-Counsel AI, un asistente legal equipado para manejar tareas complejas de investigación legal.

Las aplicaciones de RFT de OpenAI son adecuadas para campos como el derecho, la salud y la seguridad de IA

Estos ejemplos subrayan la capacidad de RFT para desbloquear nuevas eficiencias aprovechando la habilidad del aprendizaje por refuerzo para recompensar el razonamiento correcto.

La diferencia entre ajuste fino supervisado y ajuste fino por refuerzo

El ajuste fino supervisado imita estilos o tonos, mientras que RFT enseña a la IA a razonar lógicamente de nuevas maneras

En 2022, OpenAI introdujo el ajuste fino supervisado en su conjunto de herramientas API. Aunque poderoso por derecho propio, el ajuste fino supervisado se enfoca en enseñar a la IA a replicar características de los datos de entrada—útil para cambiar el tono, estilo o formato, pero menos adecuado para resolver desafíos basados en el razonamiento.

En contraste, el ajuste fino por refuerzo enfatiza enseñar a los modelos a razonar y resolver problemas. Así es como:

- Espacio de pensamiento crítico: RFT permite que el modelo de IA haga una pausa, evalúe un problema y genere soluciones lógicas basadas en evidencia.

- Aprendizaje impulsado por retroalimentación: Se recompensan las rutas de razonamiento correctas, mientras que las razones defectuosas son penalizadas. Esta retroalimentación guía al modelo hacia una mayor competencia.

- Generalización a través de dominios: Al analizar solo unos pocos ejemplos dentro de conjuntos de datos limitados, los modelos entrenados con RFT aprenden a razonar mejor en dominios personalizados.

Por ejemplo, como se discutió en la presentación, instruir a los modelos utilizando datos biomédicos resultó en mejoras notables después de exponerlos a solo unas pocas docenas de ejemplos de entrenamiento.

Adopción científica: explorando la genética con ajuste fino por refuerzo

OpenAI y los investigadores colaboran para estudiar enfermedades genéticas utilizando ajuste fino por refuerzo

Uno de los dominios más emocionantes donde se está aplicando actualmente el ajuste fino por refuerzo es la investigación científica. Justin Reese, biólogo computacional de Berkeley Lab, compartió su experiencia aprovechando los modelos de OpenAI para explorar enfermedades genéticas raras.

Las enfermedades raras pueden parecer individualmente poco comunes, sin embargo, en conjunto, afectan a más de 300 millones de personas en todo el mundo. Diagnosticar estas condiciones puede llevar a menudo meses o años debido al conocimiento especializado requerido. Al combinar el ajuste fino por refuerzo con conjuntos de datos extraídos de:

- Informes de casos médicos

- Listas de síntomas (tanto presentes como ausentes)

- Marcadores genéticos que causan enfermedades específicas

Justin y su equipo han creado un modelo de IA capaz de razonar sistemáticamente sobre mutaciones genéticas, acelerando así los flujos de trabajo de investigación y mejorando la precisión diagnóstica.

Esta colaboración multidisciplinaria—que abarca desde Berkeley Lab, el Hospital Charité en Alemania, y diversas iniciativas médicas globales—ejemplifica el potencial transformador de RFT.

Paso a paso: cómo funciona el ajuste fino por refuerzo

El entrenamiento del modelo comienza subiendo conjuntos de datos personalizados emparejados con criterios de evaluación (evaluadores)

El ajuste fino por refuerzo opera a través de un proceso estructurado:

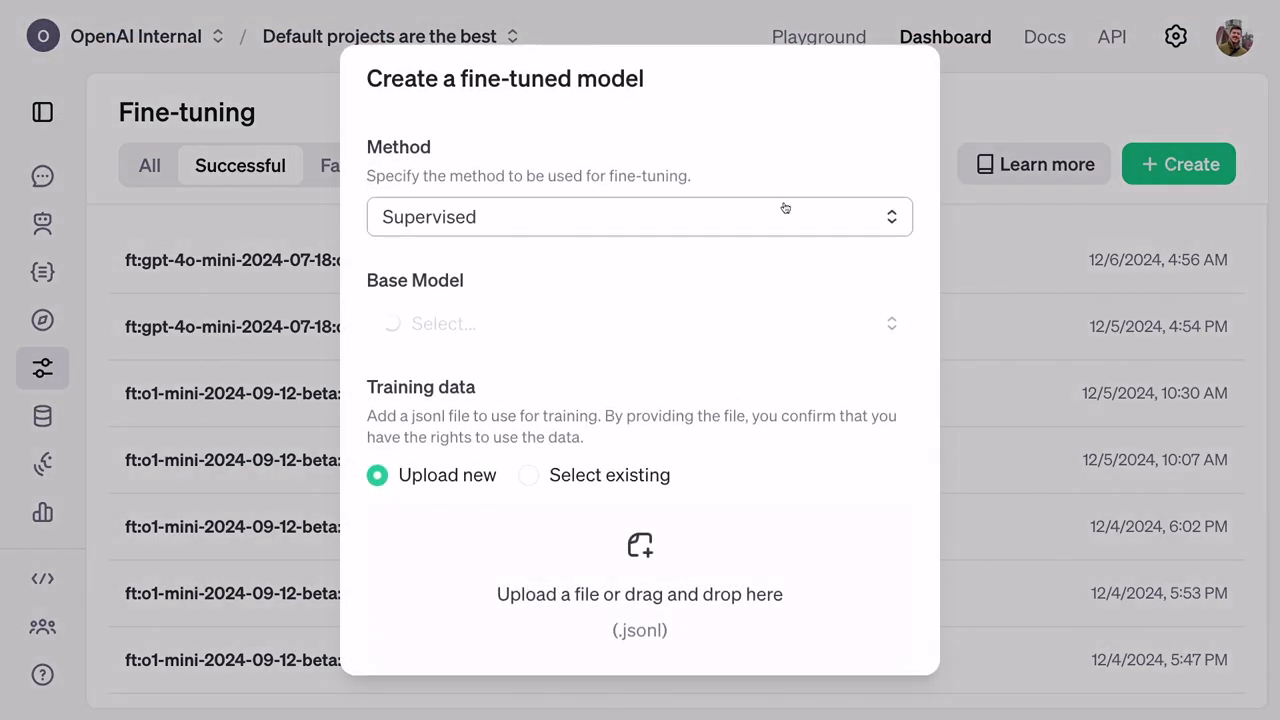

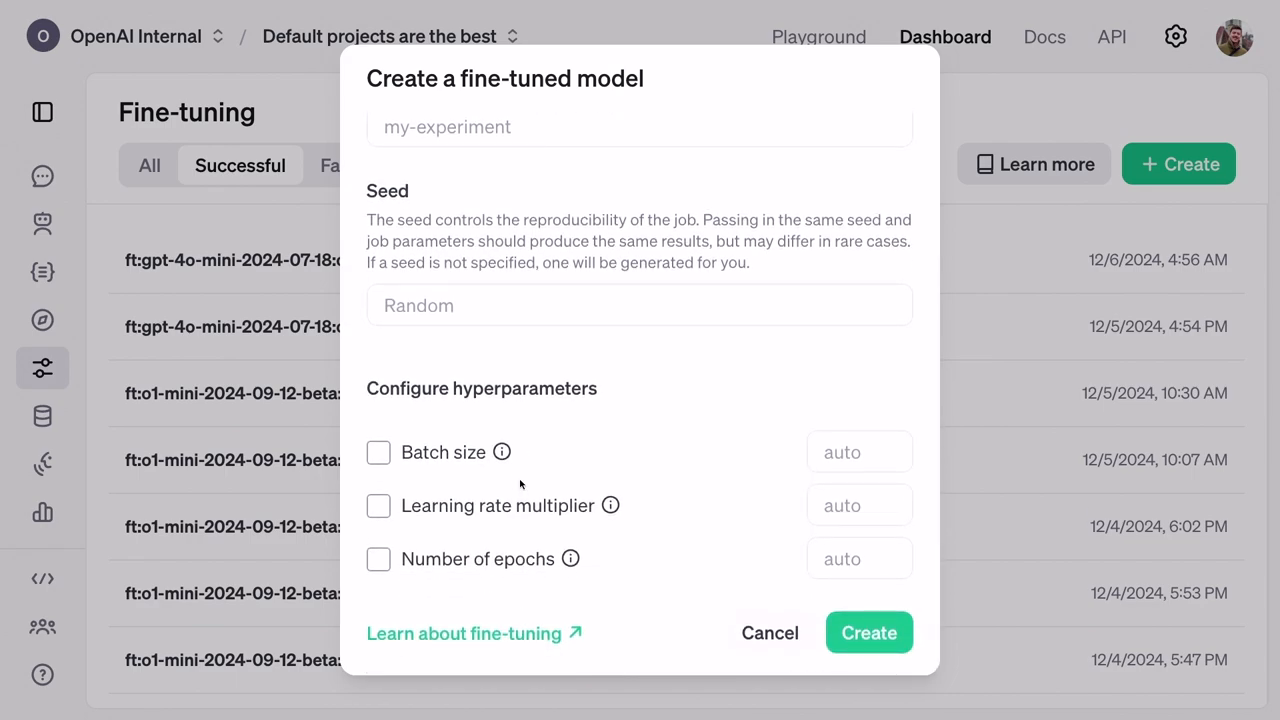

Preparación del conjunto de datos: El entrenamiento requiere archivos JSONL que contengan ejemplos personalizados. Estos incluyen entradas, instrucciones y respuestas, pero ocultan los resultados reales durante el entrenamiento del modelo para evitar trampas.

Validación: Durante el entrenamiento, los modelos también se evalúan en un conjunto de datos de validación separado para garantizar que la IA no solo memorice respuestas, sino que aplique un razonamiento genuino.

Evaluadores para puntuación: Un concepto único en RFT, los "evaluadores" son métricas de evaluación que asignan puntuaciones a las predicciones, recompensando respuestas correctas mientras desalientan patrones incorrectos.

Infraestructura de entrenamiento: Ejecutándose en los sistemas de entrenamiento distribuidos de OpenAI, el ajuste fino por refuerzo hace que técnicas de vanguardia estén disponibles para los usuarios sin requerir experiencia de ingeniería directa.

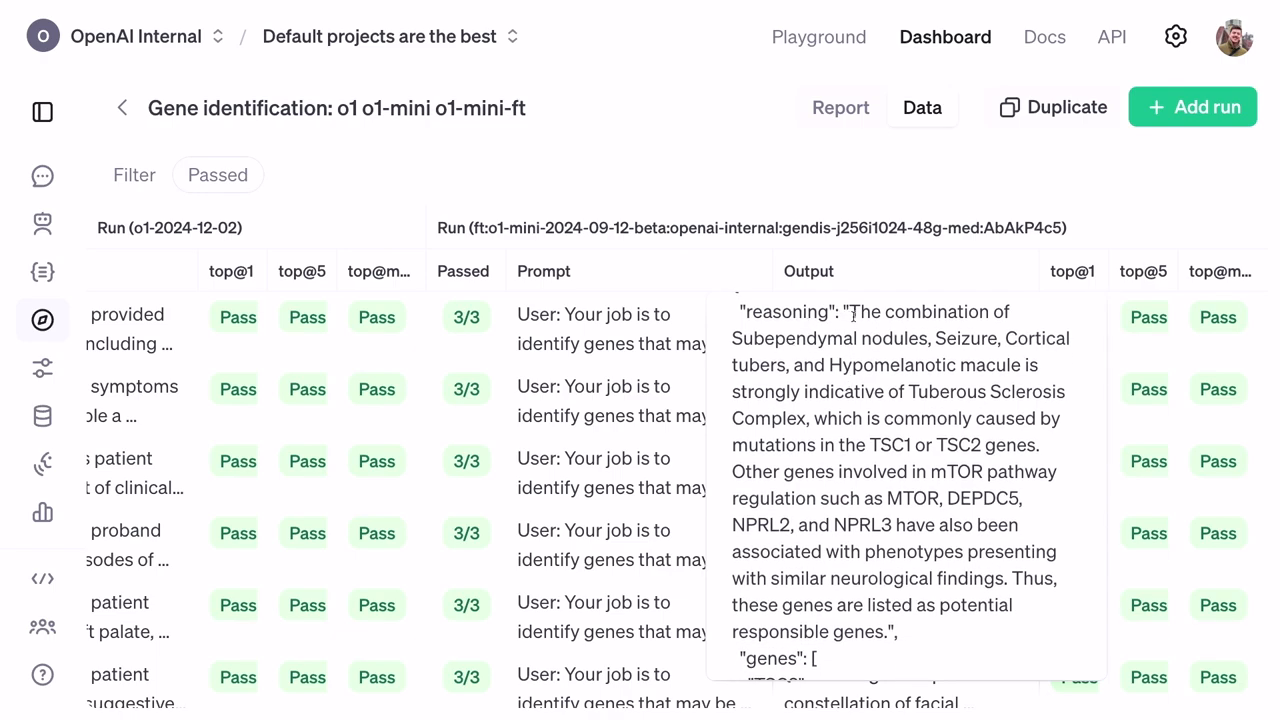

Medición del rendimiento: Las evaluaciones posteriores al entrenamiento valoran la precisión mejorada del modelo analizando métricas estadísticas como rankings top-at-1 y top-at-5, mostrando la robustez del modelo ajustado.

El ajuste fino mejora la precisión para identificar genes responsables utilizando clasificaciones jerárquicas.

Implicaciones en el mundo real: resultados de rendimiento y razonamiento

Las puntuaciones basadas en validación demuestran las habilidades de razonamiento más finas desbloqueadas tras el ajuste.

Con sus modelos afinados por refuerzo superando los ajustes tradicionales, los resultados demostraron cómo incluso modelos más pequeños y baratos pueden superar en última instancia a líneas base más intensivas en recursos. La mejora en la precisión fue especialmente evidente en las clasificaciones del O1 Mini, que lograron un mejor razonamiento y tasas de éxito significativamente más altas para predecir genes basados en síntomas.

Además, los resultados procesables incluyeron explicaciones para las decisiones de la IA, permitiendo a investigadores como Justin Reese explorar caminos de razonamiento exactos—una característica crucial para diagnósticos vitales.

Mirando hacia adelante: ajuste fino por refuerzo para casos de uso más amplios

OpenAI anuncia un programa de investigación expandido para aprovechar el ajuste fino por refuerzo.

El potencial del ajuste fino por refuerzo se extiende mucho más allá de la atención médica, ya que OpenAI demostró su flexibilidad en industrias como bioinformática, seguridad de IA y sistemas legales. Mientras tanto, el recién expandido programa de investigación Alpha de OpenAI abre oportunidades para que universidades y empresas piloten modelos ajustados por refuerzo dentro de sus dominios nicho.

Esta iniciativa invita a líderes involucrados en tareas complejas a probar soluciones de vanguardia antes del lanzamiento público, previsto para principios de 2024.

Conclusión: uniendo la innovación con las necesidades del dominio

El ajuste fino por refuerzo presenta un potencial infinito para aplicaciones de IA específicas de tareas

El ajuste fino por refuerzo significa un salto monumental en la forma en que la IA interactúa con tareas especializadas, desde biología hasta finanzas. Al combinar el razonamiento lógico con datos ajustados por expertos, OpenAI allana el camino para sistemas de IA capaces de pensar de manera más crítica, generalizar inteligentemente y resolver los problemas más difíciles de la humanidad.

Mientras las aplicaciones de RFT aún están evolucionando, su impacto actual anticipa un futuro donde los sistemas de IA adaptables se vuelvan indispensables tanto en sectores académicos como industriales. El camino sigue claro: combinar la experiencia del dominio con la infraestructura escalable de OpenAI para ser pioneros en soluciones para las fronteras tecnológicas del mañana.