Apache spark: một công cụ cách mạng cho phân tích dữ liệu lớn và máy học

Trong một thế giới mà dữ liệu là dầu mỏ mới, việc xử lý và hiểu biết lượng thông tin khổng lồ là nền tảng của sự tiến bộ công nghệ. Apache Spark đã nổi lên như một trong những công cụ vững chắc và mạnh mẽ nhất để xử lý dữ liệu lớn một cách hiệu quả. Công cụ phân tích dữ liệu mã nguồn mở này đã cách mạng hóa cách mà các tổ chức xử lý và phân tích các dòng dữ liệu khổng lồ. Hãy cùng đi sâu vào các khái niệm về Apache Spark, khám phá lịch sử của nó, so sánh nó với các công nghệ khác, và hiểu cách nó xử lý các nhiệm vụ dữ liệu phức tạp như một chuyên gia.

What is apache spark?

Apache Spark là một động cơ phân tích dữ liệu tiên tiến.

Apache Spark là một động cơ phân tích dữ liệu mã nguồn mở được thiết kế để xử lý các dòng dữ liệu khổng lồ từ nhiều nguồn theo thời gian thực hoặc chế độ lô. Khả năng của Spark trong việc xử lý các phép toán phức tạp giống như "một con bạch tuộc tung hứng với cưa." Nó chuyên về xử lý dữ liệu phân tán và đạt được tốc độ vượt trội bằng cách thực hiện các phép toán trong bộ nhớ, khiến nó nhanh hơn đến 100 lần so với các hệ thống dựa vào đĩa truyền thống.

The origins of apache spark

Apache Spark được tạo ra tại AMP Lab của UC Berkeley.

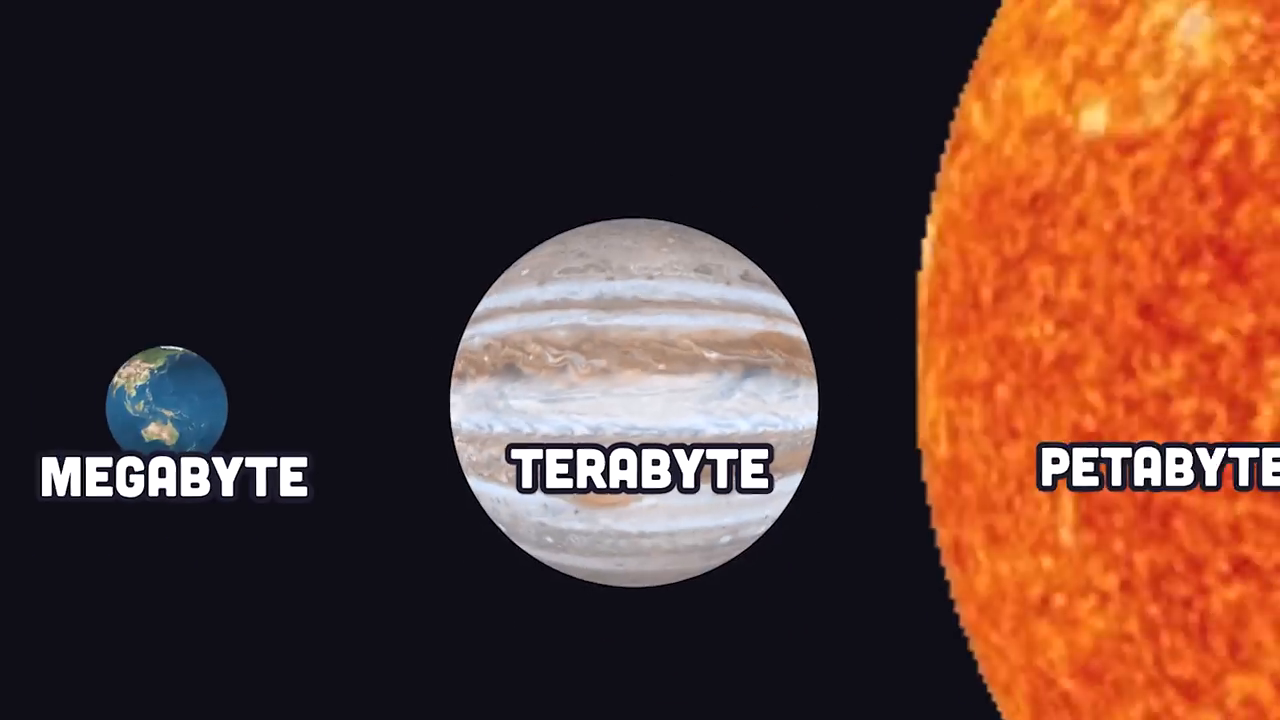

Apache Spark có nguồn gốc từ năm 2009, nhờ vào Matei Zaharia tại AMP Lab của UC Berkeley. Trong thời gian này, sự tạo ra dữ liệu trên internet đang chứng kiến sự tăng trưởng nổ ra, từ megabyte đến petabyte. Việc thực hiện phân tích trên khối lượng dữ liệu này bằng các máy đơn lẻ trở nên gần như không thể. Nhu cầu đang tăng cao này đã thúc đẩy sự phát triển của Apache Spark, cung cấp cho các nhà nghiên cứu và doanh nghiệp một công cụ để xử lý các tập dữ liệu lớn trên các hệ thống phân tán.

Apache spark vs hadoop: the battle of big data tools

Apache Spark giới thiệu xử lý dữ liệu trong bộ nhớ so với quy trình dựa vào đĩa của Hadoop.

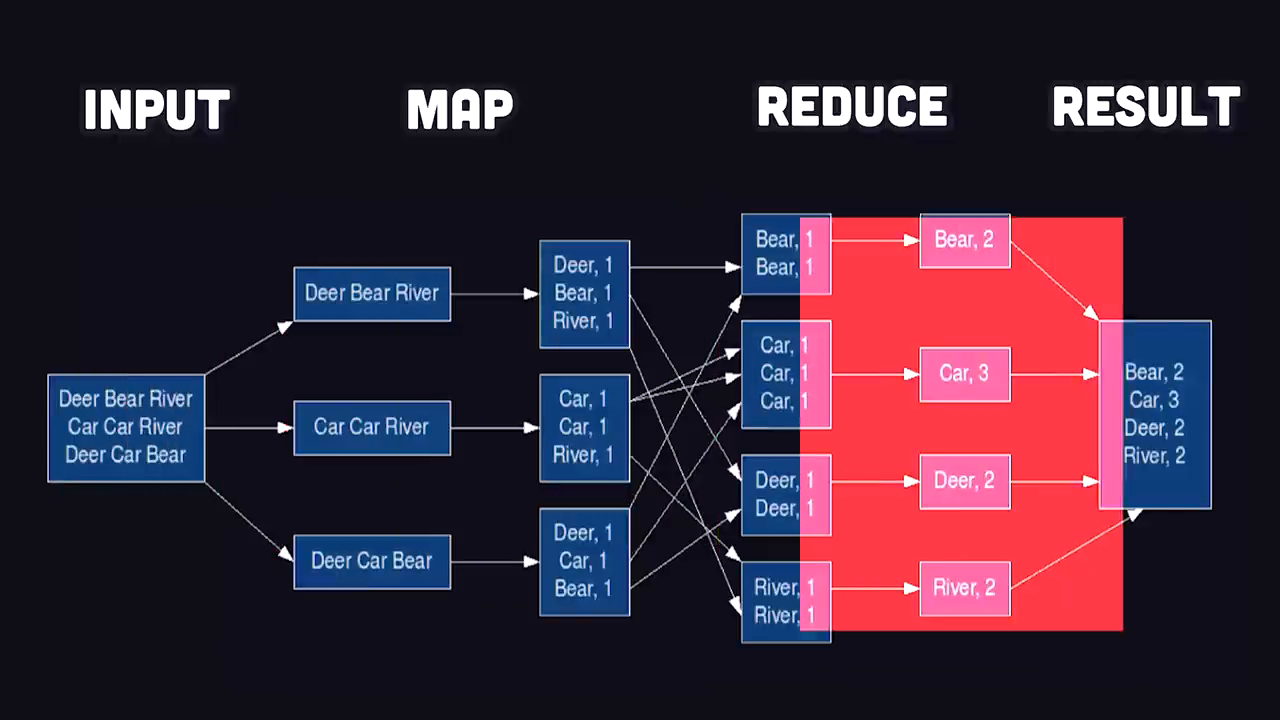

Trước khi Apache Spark xuất hiện, MapReduce của Hadoop là nhân tố chủ yếu trong phân tích dữ liệu lớn. MapReduce sử dụng một mô hình lập trình trong đó dữ liệu được ánh xạ thành các cặp khóa-giá trị, được xáo trộn, sắp xếp và giảm thiểu thành các kết quả cuối cùng. Mặc dù hiệu quả trong việc xử lý các tập dữ liệu phân tán, MapReduce đã gặp phải các tắc nghẽn do dựa vào các thao tác nhập/xuất (I/O) dựa vào đĩa.

Apache Spark đã thay đổi cuộc chơi bằng cách giới thiệu một cách tiếp cận xử lý dữ liệu trong bộ nhớ. Thay vì đọc và ghi các kết quả trung gian vào đĩa, Spark xử lý dữ liệu trong RAM, tăng tốc quá trình tính toán một cách đáng kể. Sự đổi mới này đã loại bỏ các nút thắt I/O, khiến Spark nhanh hơn đến 100 lần so với các đối thủ.

Real-world use cases of apache spark

Apache Spark cung cấp phân tích dữ liệu cho các công ty Fortune 500, NASA và nhiều hơn nữa.

Apache Spark cung cấp sức mạnh cho một số tổ chức lớn nhất thế giới trên nhiều ngành nghề:

- Amazon: Spark giúp phân tích dữ liệu thương mại điện tử, biến đổi trải nghiệm khách hàng với các gợi ý và dự đoán có mục tiêu.

- Phòng thí nghiệm đẩy của NASA: Nó sử dụng Spark để xử lý một lượng lớn dữ liệu không gian, khám phá chiều sâu của vũ trụ.

- 80% công ty Fortune 500: Spark đã trở thành giải pháp được ưa chuộng cho các doanh nghiệp xử lý các đường ống dữ liệu lớn phức tạp và nhu cầu phân tích.

Mặc dù có danh tiếng là một công cụ tính toán phân tán, Spark cũng có thể chạy cục bộ, khiến nó dễ tiếp cận cho các dự án quy mô nhỏ và các nhà phát triển cá nhân.

How apache spark works

Getting started with apache spark

Apache Spark cho phép xử lý cục bộ và phân tán thông qua các API dễ sử dụng.

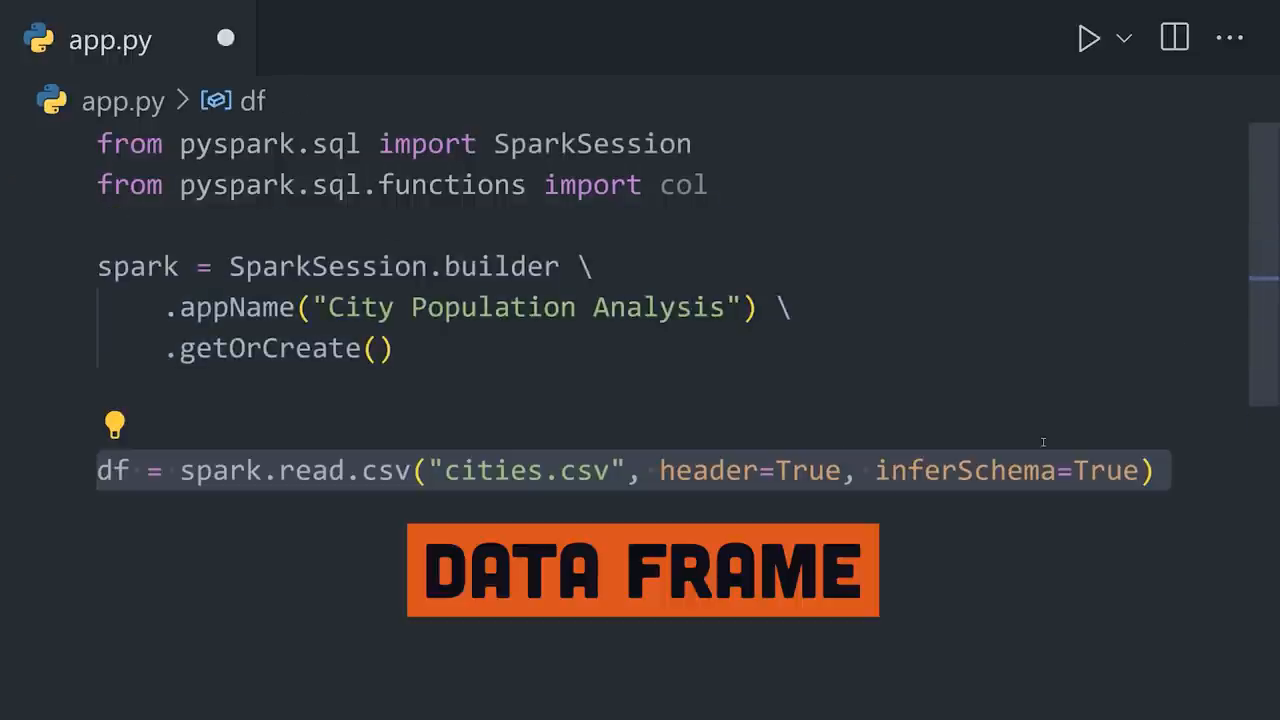

Apache Spark chủ yếu được viết bằng Java và chạy trên Java Virtual Machine (JVM). Tuy nhiên, các API của nó hỗ trợ nhiều ngôn ngữ như Python (thông qua PySpark), SQL và Scala, giúp Spark dễ tiếp cận cho một cơ sở phát triển rộng lớn. Để bắt đầu, bạn cần cài đặt Spark và khởi tạo một phiên.

Solving real-world problems with spark

API Spark DataFrame cho phép lọc dữ liệu thực tế một cách trực quan.

Hãy tưởng tượng bạn có một tệp CSV với dữ liệu về các thành phố, bao gồm dân số, vĩ độ và kinh độ. Nhiệm vụ của bạn là tìm thành phố đông dân nhất nằm giữa các vùng nhiệt đới. Đây là cách mà Spark xử lý bước này từng bước một:

- Tải dữ liệu vào bộ nhớ: Spark đọc tệp CSV và lưu trữ nó dưới dạng khung dữ liệu, biến đổi các hàng và cột thành các đối tượng có thể được xử lý trong bộ nhớ trên nhiều hệ thống phân tán.

- Lọc dữ liệu: Loại bỏ các thành phố bên ngoài vùng nhiệt đới bằng cách sử dụng các hàm biến đổi mạnh mẽ của Spark.

- Sắp xếp và chọn kết quả: Sắp xếp các kết quả đã lọc theo dân số và lấy thành phố có dân số cao nhất. Spark làm cho toàn bộ quá trình này trở nên liền mạch thông qua việc gọi phương thức theo chuỗi với API DataFrame của mình.

Trong ví dụ này, Spark xác định Thành phố Mexico là thành phố có dân số nhiệt đới lớn nhất.

Spark with sql and distributed clusters

Spark tích hợp với các cơ sở dữ liệu SQL và hỗ trợ mở rộng cụm.

Đối với những người làm việc với các cơ sở dữ liệu SQL, Spark cung cấp tích hợp dễ dàng để truy vấn dữ liệu trực tiếp, nâng cao khả năng sử dụng của nó cho các kỹ sư cơ sở dữ liệu. Ngoài ra, khi xử lý các tập dữ liệu khổng lồ, quản lý cụm của Spark hoặc các công cụ điều phối container như Kubernetes có thể mở rộng khối lượng công việc theo chiều ngang trên vô số máy, đạt được xử lý phân tán tốt nhất.

Apache spark for machine learning at scale

MLlib của Spark đơn giản hóa máy học quy mô lớn.

Apache Spark cũng tỏa sáng trong máy học thông qua thư viện mạnh mẽ của nó được gọi là MLlib. Bằng cách phân phối dữ liệu qua các cụm, Spark xây dựng các đường ống máy học có thể mở rộng một cách dễ dàng. Ví dụ:

- Bộ ghép vector: MLlib cho phép các nhà phát triển kết hợp nhiều cột thành một cột vector duy nhất.

- Chia dữ liệu: Chia dữ liệu thành các bộ huấn luyện và kiểm tra cho các mô hình máy học.

- Chọn thuật toán: MLlib hỗ trợ các thuật toán cho phân loại, hồi quy, phân cụm, và nhiều hơn nữa.

Sự huấn luyện phân tán này đảm bảo rằng các mô hình có thể tận dụng khả năng xử lý dữ liệu quy mô lớn của Spark để đưa ra các dự đoán chính xác.

Education and tools to get started with spark

Kỹ năng lập trình và phân tích có thể mở khóa tiềm năng đầy đủ của Spark.

Mặc dù Spark là một công cụ mạnh mẽ, nhưng khai thác hết tiềm năng của nó yêu cầu một nền tảng vững chắc về lập trình, phân tích dữ liệu, và các chiến lược giải quyết vấn đề. Các nền tảng như Brilliant.org có thể giúp cá nhân xây dựng những kỹ năng quan trọng này thông qua các bài học hấp dẫn và bài tập thực hành. Đầu tư thời gian để cải thiện tư duy logic và thói quen lập trình có thể cải thiện đáng kể khả năng của bạn với những công cụ như Apache Spark.

Conclusion

Apache Spark mở khóa tiềm năng của phân tích dữ liệu lớn có thể mở rộng.

Apache Spark tiếp tục chuyển mình phân tích dữ liệu lớn với tính toán trong bộ nhớ, tính mở rộng, và tích hợp với các công nghệ máy học. Nó đã trở thành một viên đá nền tảng cho các lĩnh vực từ học thuật và nghiên cứu đến các doanh nghiệp công nghiệp. Dù bạn đang phân tích xu hướng thương mại điện tử, xử lý dữ liệu không gian sâu, hay huấn luyện các mô hình ML quy mô lớn, Spark mang lại hiệu suất và hiệu quả không gì sánh kịp.

Khi chúng ta đứng trên đôi vai của những công cụ cách mạng như Apache Spark, điều cần thiết là phải tiếp tục học hỏi và phát triển kỹ năng của mình để thích ứng với bối cảnh công nghệ không ngừng thay đổi. Vậy tại sao không bắt đầu bước đầu tiên vào thế giới của Spark và dữ liệu lớn ngay hôm nay?