Thực hiện Trợ lý Chia sẻ Màn hình Thời gian thực với Giọng nói và Bản ghi bằng các mô hình Gemini 2.0 và Gemini 1.5

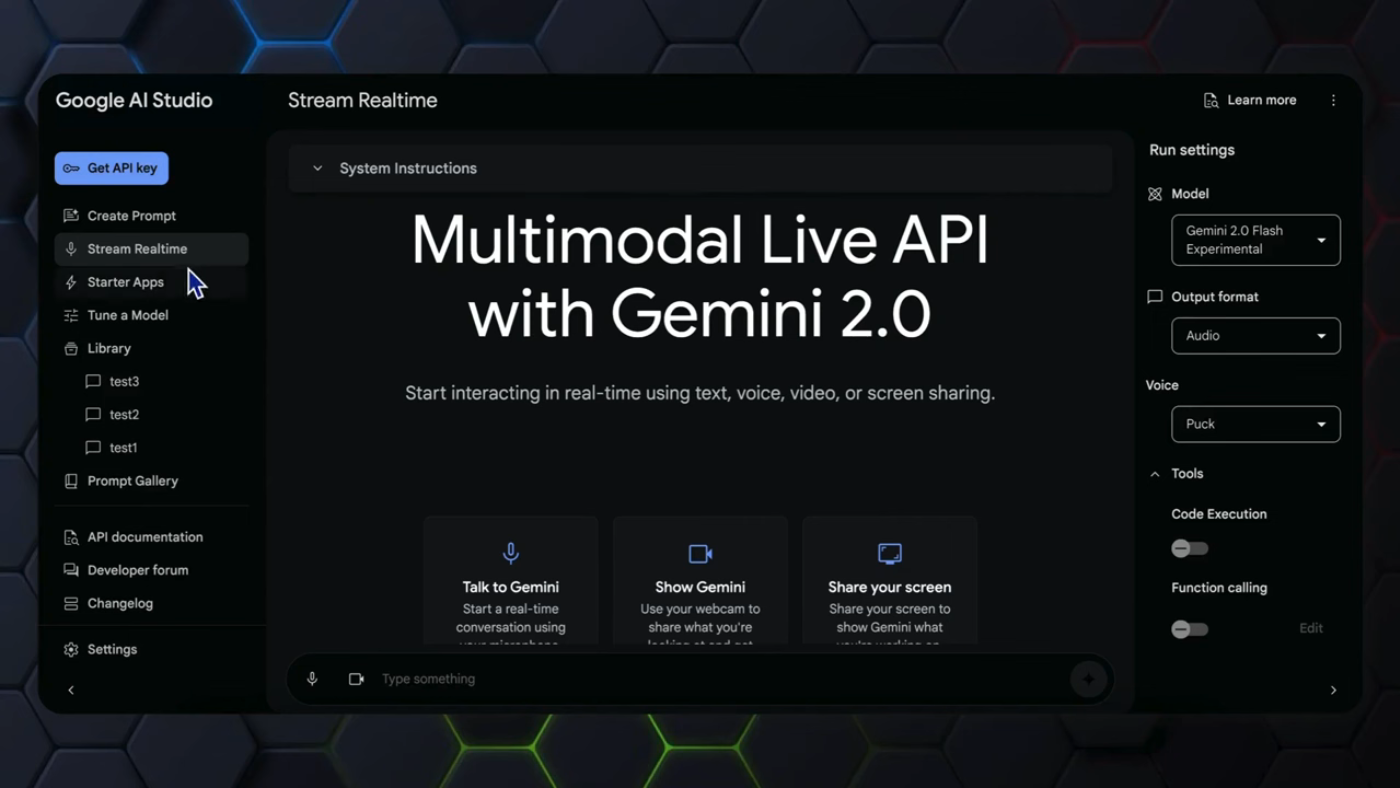

Trong bài viết này, chúng ta sẽ khám phá cách thực hiện trợ lý chia sẻ màn hình thời gian thực với giọng nói và bản ghi bằng cách sử dụng các mô hình Gemini 2.0 và Gemini 1.5. Gemini multi-modal live API đã được sử dụng trong các video trước đây để minh họa khả năng của nó, bao gồm các tương tác thời gian thực thông qua văn bản, giọng nói và camera, cùng với việc chia sẻ màn hình.

Giới thiệu về Gemini Multi-Modal Live API

Gemini multi-modal live API là một công cụ mạnh mẽ cho phép các tương tác thời gian thực thông qua văn bản, giọng nói và camera, cùng với việc chia sẻ màn hình. Tuy nhiên, vẫn còn một vấn đề quan trọng ngăn cản việc triển khai ứng dụng trong thế giới thực, đó là không thể cung cấp cả văn bản và phản hồi âm thanh thời gian thực.  Giới thiệu về Gemini Multi-Modal Live API

Giới thiệu về Gemini Multi-Modal Live API

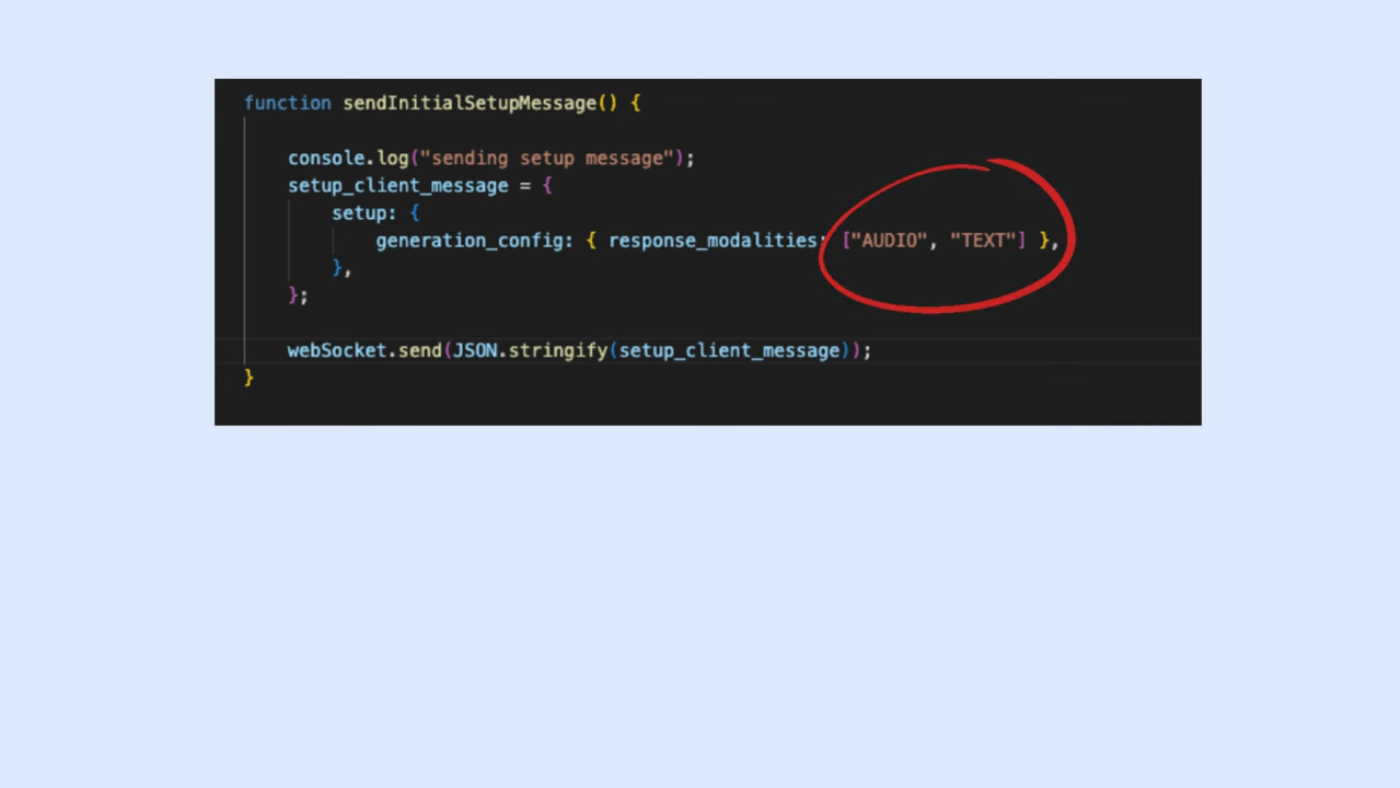

Vấn đề Còn Lại của Gemini API

Tham số "response_modality" trong thư viện được cho phép đặt là danh sách "audio" cộng với "text," nhưng chế độ đặt này không hoạt động như mong đợi, chỉ xuất hiện lỗi liên tục.  Vấn đề Còn Lại của Gemini API

Vấn đề Còn Lại của Gemini API

Kiến trúc Dự án

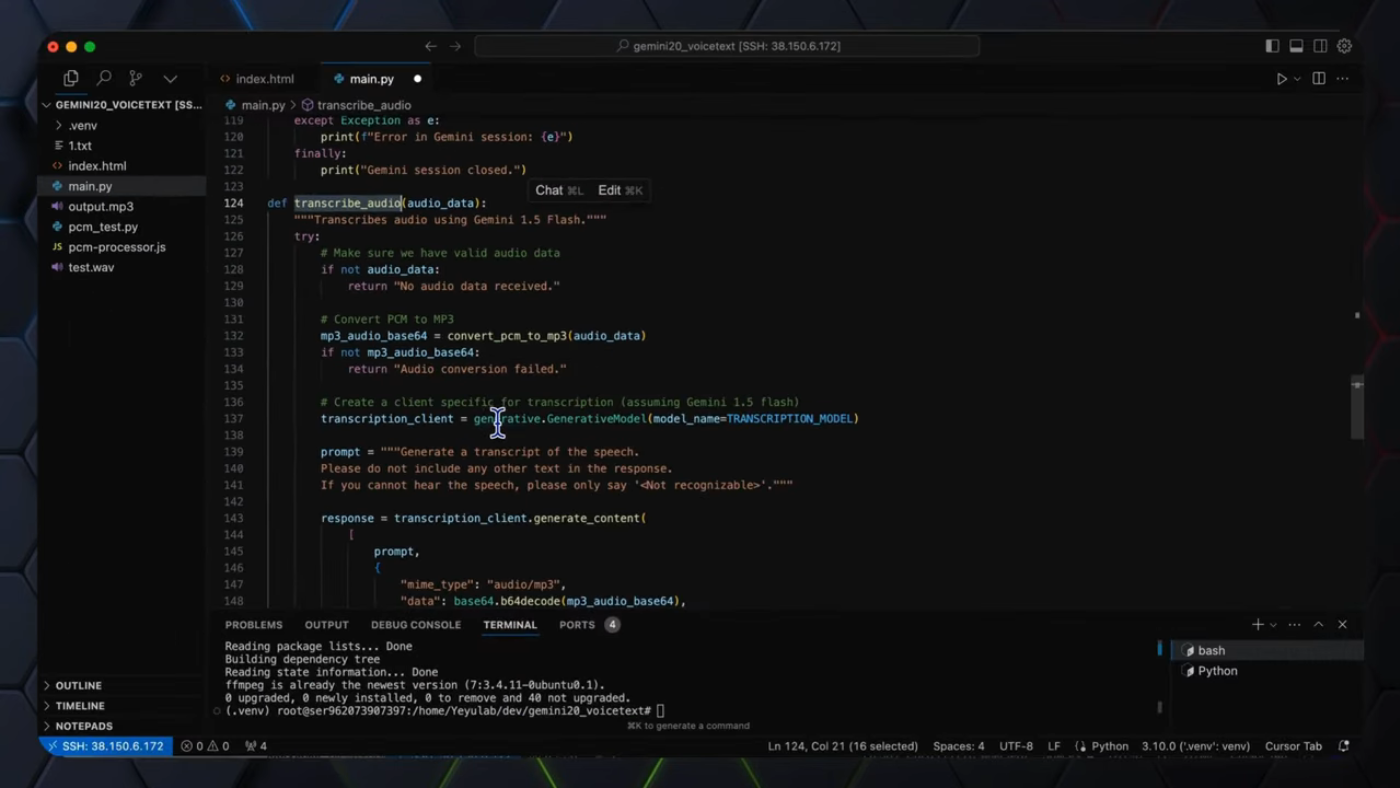

Ứng dụng sử dụng hai mô hình Gemini trong một quy trình được tối ưu hóa. Đầu tiên, khách hàng gửi các đầu vào hình ảnh và âm thanh tới máy chủ. Máy chủ sau đó sử dụng mô hình Gemini 2.0 Flash để tạo ra luồng âm thanh thời gian thực. Tiếp theo, máy chủ sử dụng đầu ra này để chuyển đổi âm thanh thành văn bản bằng mô hình Gemini 1.5 Flash 8B.  Kiến trúc Dự án

Kiến trúc Dự án

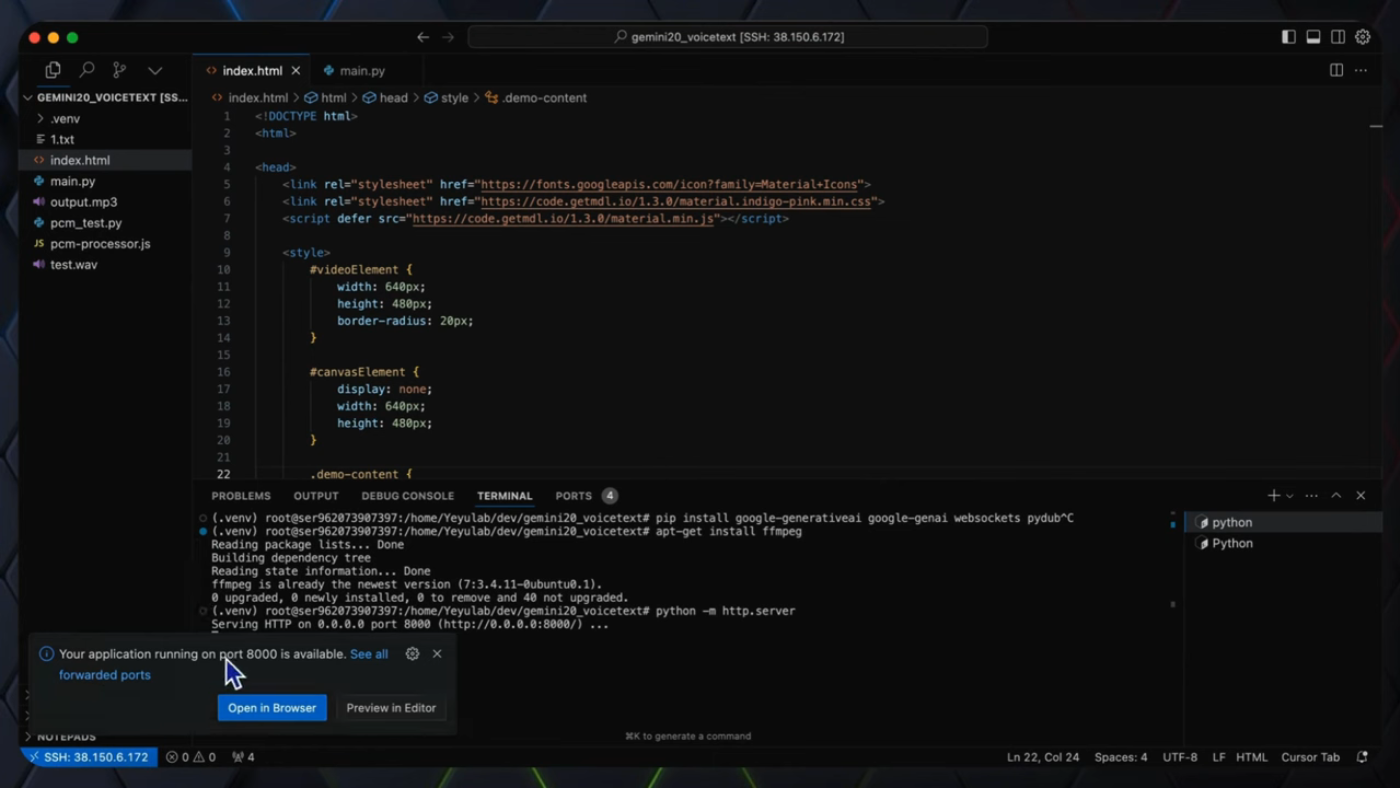

Hướng dẫn Mã nguồn

Mã nguồn máy chủ chịu trách nhiệm xử lý thông điệp cấu hình từ khách hàng, kết nối với Gemini 2.0 multi-modal live API và gửi/nhận dữ liệu. Hàm "gemini_session_handler" được sử dụng để xử lý kết nối WebSocket và trao đổi dữ liệu với Gemini 2.0 multi-modal live API.  Hướng dẫn Mã nguồn

Hướng dẫn Mã nguồn

ChạyỨng dụng

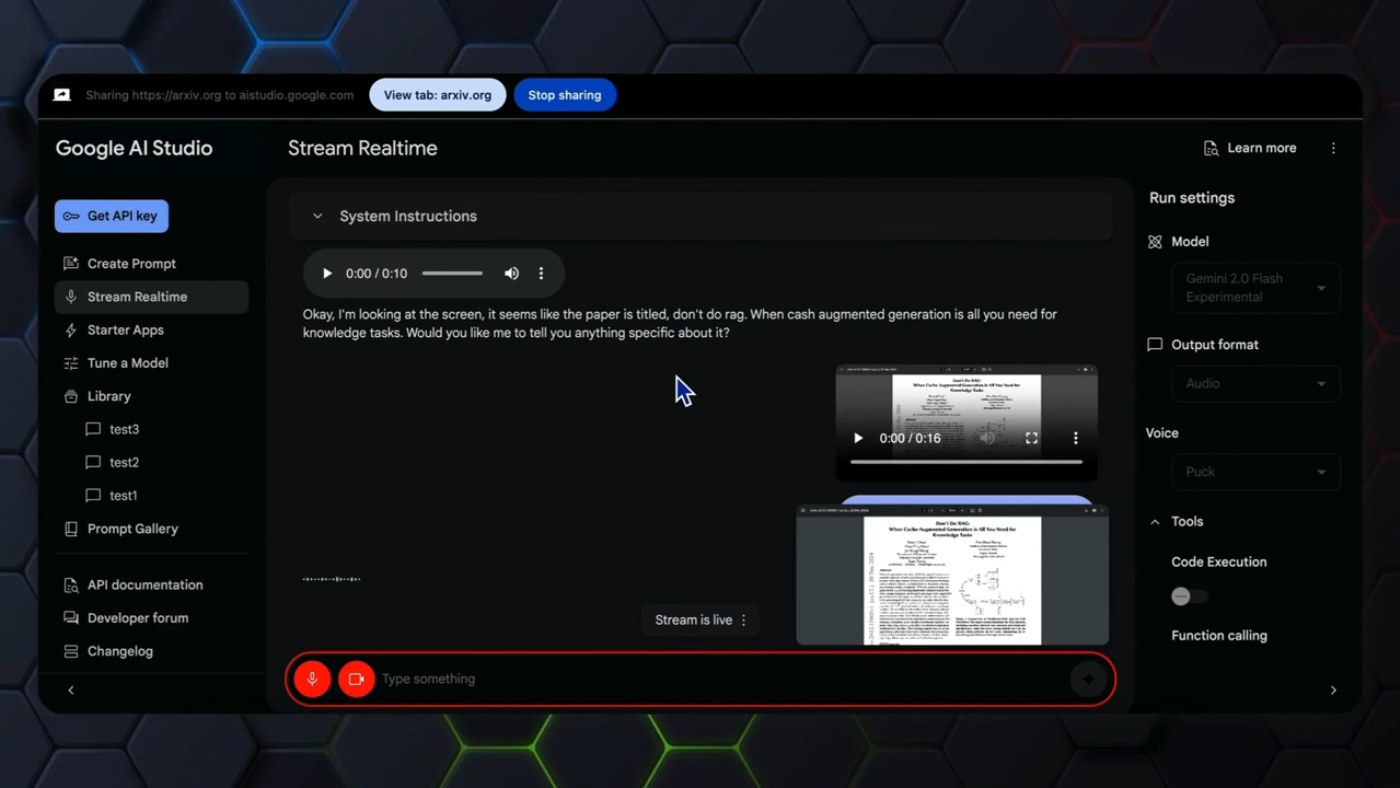

Quá trình chia sẻ màn hình thời gian thực được triển khai bằng Gemini 2.0 multi-modal live API trong video trước. Các tính năng cải tiến về văn bản và âm thanh nằm ở máy chủ phía sau, và mã nguồn phía trước có thể được sao chép từ repository GitHub.  ChạyỨng dụng

ChạyỨng dụng

Kết luận

Tóm lại, video này giải quyết hạn chế của Gemini multi-modal live API bằng cách cung cấp cả bản ghi có thể đọc được và phản hồi âm thanh để thực hiện trợ lý chia sẻ màn hình thời gian thực. Ứng dụng sử dụng hai mô hình Gemini trong một quy trình được tối ưu hóa, và mã nguồn máy chủ chịu trách nhiệm xử lý thông điệp cấu hình từ khách hàng, kết nối với Gemini 2.0 multi-modal live API và gửi/nhận dữ liệu.  Kết luận

Kết luận

Phát triển Tương lai

Gemini multi-modal live API vẫn đang ở giai đoạn đầu, và còn nhiều cơ hội để phát triển trong tương lai. Sự sử dụng của hai mô hình khác nhau, Gemini 2.0 Flash và Gemini 1.5 Flash 8B, cung cấp giải pháp hiệu quả và tiết kiệm chi phí cho việc tạo ra luồng âm thanh thời gian thực và quá trình chuyển đổi âm thanh thành văn bản.  Phát triển Tương lai

Phát triển Tương lai