Sự khởi đầu của fine-tuning tăng cường: mở khóa biên giới tiếp theo trong sự đa dạng của AI

Fine-tuning tăng cường (RFT) đang ra mắt như một trong những bước tiến quan trọng nhất trong việc tùy chỉnh mô hình AI. Mới đây, phương pháp tiên tiến này đã được giới thiệu trong một buổi thuyết trình của OpenAI, hứa hẹn sẽ cách mạng hóa cách các nhà phát triển, nhà nghiên cứu và doanh nghiệp tối ưu hóa các mô hình AI cho các nhiệm vụ cụ thể. Được dẫn dắt bởi đội ngũ OpenAI, buổi thuyết trình đã tiết lộ sức mạnh của việc kết hợp các kỹ thuật học tăng cường với fine-tuning có thể tùy chỉnh, một bước nhảy vọt giúp cho các mô hình AI tiên tiến như GPT-4 và loạt O1 trở nên linh hoạt hơn bao giờ hết.

Bài viết này đi sâu vào những hiểu biết từ bản ghi chép của buổi thuyết trình, khám phá lý do, nội dung và cách thức của fine-tuning tăng cường, cùng với các ứng dụng thực tế của nó.

Đổi mới mới nhất của OpenAI: O1 và fine-tuning tăng cường

OpenAI giới thiệu fine-tuning tăng cường với các mô hình O1 có thể tùy chỉnh

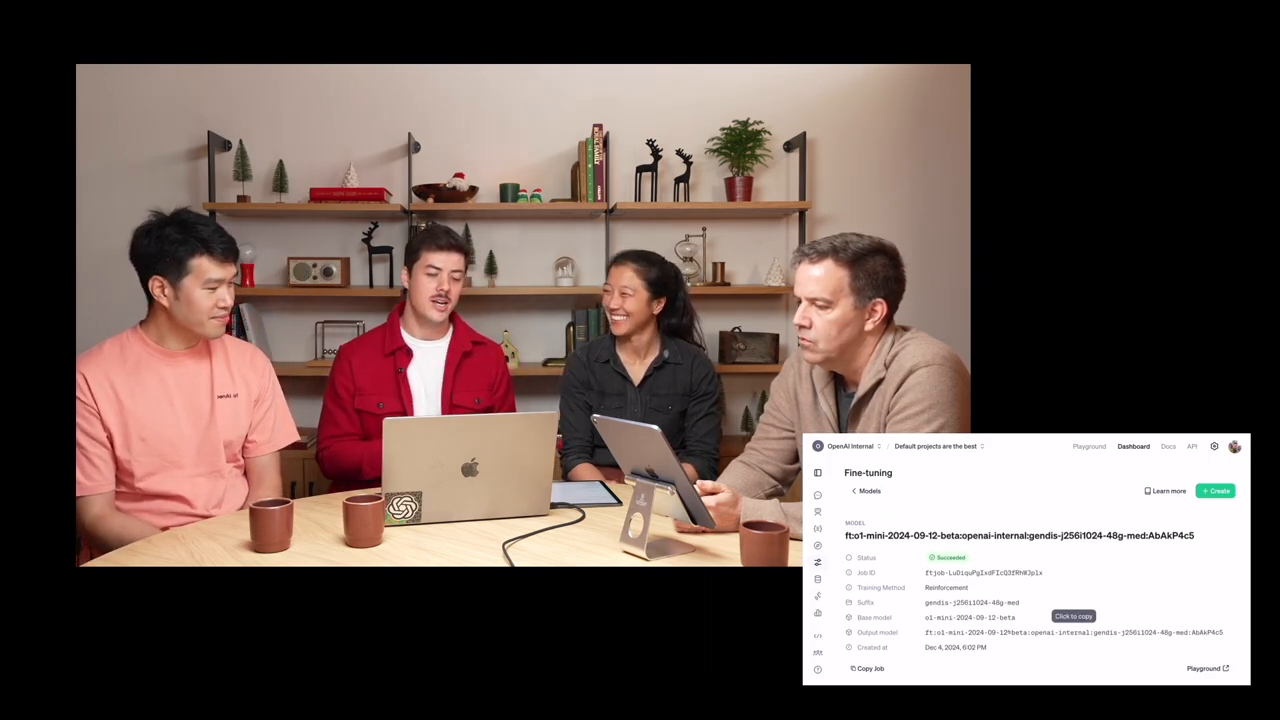

Mark, một nhà nghiên cứu trưởng tại OpenAI, đã bắt đầu phiên họp bằng cách giới thiệu loạt mô hình mới nhất của họ, O1. Mới được ra mắt, loạt mô hình O1 có sự cải tiến đáng kể trong cách tiếp cận giải quyết vấn đề; các mô hình "suy nghĩ" trong một thời gian trước khi tạo ra phản hồi, thể hiện quá trình ra quyết định tinh vi hơn.

Fine-tuning tăng cường xây dựng trên sự đổi mới đó bằng cách cho phép các nhà phát triển và tổ chức thích ứng các mô hình O1 sử dụng dữ liệu của riêng họ—không thông qua fine-tuning truyền thống, mà với các nguyên tắc học tăng cường.

Sự tiến bộ này không chỉ đơn thuần là việc bắt chước các đầu vào hiện có; thay vào đó, nó cho phép các mô hình suy nghĩ một cách hệ thống hơn. Bằng cách cho các mô hình "không gian để suy nghĩ," như Mark đã giải thích, cách tiếp cận này tối ưu hóa các quy trình suy luận, tăng cường khả năng tổng quát, và trao quyền cho người dùng tạo ra các mô hình chuyên gia cụ thể cho từng miền.

Tại sao fine-tuning tăng cường quan trọng

Khả năng tinh chỉnh các mô hình AI có tiềm năng to lớn, đặc biệt đối với các tổ chức xử lý dữ liệu chuyên biệt. Fine-tuning tăng cường tách biệt bản thân bằng việc cho phép phát triển các công cụ AI vượt ra ngoài việc khớp các mẫu; nó cho phép suy luận logic trên dữ liệu. OpenAI đã nêu rõ một số lĩnh vực chính mà quy trình fine-tuning tăng cường O1 của họ cung cấp các trường hợp sử dụng biến đổi:

- Luật & Tài chính: Phát triển các công cụ cụ thể cho ngành phụ thuộc vào phân tích dựa trên logic.

- Kỹ thuật & Bảo hiểm: Suy luận cụ thể cho những nhiệm vụ được tối ưu hóa cho các quy trình tư duy có cấu trúc và hệ thống.

- Chăm sóc sức khỏe & Sinh học: Hỗ trợ các nhà nghiên cứu trong các lĩnh vực như phân tích di truyền và phát triển thuốc.

Ví dụ, sự hợp tác gần đây của OpenAI với Thomson Reuters đã sử dụng fine-tuning tăng cường để nâng cao Co-Counsel AI, một trợ lý pháp lý được trang bị để xử lý các nhiệm vụ nghiên cứu pháp lý phức tạp.

Các ứng dụng RFT của OpenAI phù hợp với các lĩnh vực như luật, chăm sóc sức khỏe và an toàn AI

Những ví dụ này nhấn mạnh khả năng của RFT trong việc mở khóa những hiệu quả mới bằng cách tận dụng khả năng ghi nhận suy luận đúng.

Sự khác biệt giữa fine-tuning có giám sát và fine-tuning tăng cường

Fine-tuning có giám sát phản chiếu các phong cách hoặc tông màu, trong khi RFT dạy AI suy luận logic theo những cách mới

Năm 2022, OpenAI đã giới thiệu fine-tuning có giám sát vào bộ công cụ API của mình. Mặc dù mạnh mẽ theo cách riêng, fine-tuning có giám sát tập trung vào việc dạy AI sao chép các đặc điểm từ dữ liệu đầu vào—hữu ích cho việc thay đổi tông màu, phong cách hoặc định dạng nhưng không phù hợp cho việc giải quyết các thách thức dựa trên suy luận.

Trái lại, fine-tuning tăng cường nhấn mạnh dạy các mô hình suy nghĩ và giải quyết vấn đề. Đây là cách mà nó hoạt động:

- Không gian tư duy phản biện: RFT cho phép mô hình AI dừng lại, đánh giá một vấn đề và tạo ra các giải pháp logic dựa trên bằng chứng.

- Học tập dựa trên phản hồi: Các con đường suy luận đúng được thưởng, trong khi lý do sai bị trừng phạt. Phản hồi này hướng dẫn mô hình hướng tới khả năng cao hơn.

- Khả năng tổng quát giữa các miền: Bằng cách phân tích chỉ một vài ví dụ trong các tập dữ liệu hạn chế, các mô hình được đào tạo với RFT học cách suy luận tốt hơn trong các miền tùy chỉnh.

Ví dụ, như đã thảo luận trong buổi thuyết trình, việc hướng dẫn các mô hình bằng dữ liệu sinh học đã mang lại những cải tiến rõ rệt sau khi tiếp xúc với chỉ vài chục ví dụ đào tạo.

Khám phá khoa học: nghiên cứu di truyền với fine-tuning tăng cường

OpenAI và các nhà nghiên cứu hợp tác để nghiên cứu các bệnh di truyền bằng cách sử dụng fine-tuning tăng cường

Một trong những lĩnh vực thú vị mà fine-tuning tăng cường hiện đang được áp dụng là nghiên cứu khoa học. Nhà sinh học tính toán Justin Reese của Berkeley Lab đã chia sẻ kinh nghiệm của mình trong việc tận dụng các mô hình của OpenAI để khám phá các bệnh di truyền hiếm gặp.

Các bệnh hiếm có thể có vẻ không phổ biến, nhưng tổng thể ảnh hưởng đến hơn 300 triệu người trên toàn cầu. Việc chẩn đoán những điều kiện này thường có thể mất vài tháng hoặc năm do kiến thức chuyên môn cần thiết. Bằng cách kết hợp fine-tuning tăng cường với các tập dữ liệu trích xuất từ:

- Báo cáo tình huống y tế

- Danh sách các triệu chứng (có và không có)

- Các chỉ thị di truyền gây ra bệnh cụ thể

Justin và nhóm của anh ấy đã xây dựng một mô hình AI có khả năng suy luận hệ thống về các đột biến di truyền, do đó tăng tốc quy trình nghiên cứu và nâng cao độ chính xác trong chẩn đoán.

Sự hợp tác đa ngành này—bao gồm Berkeley Lab, Bệnh viện Charité ở Đức và các sáng kiến y tế toàn cầu—thể hiện tiềm năng biến đổi của RFT.

Bước từng bước: cách mà fine-tuning tăng cường hoạt động

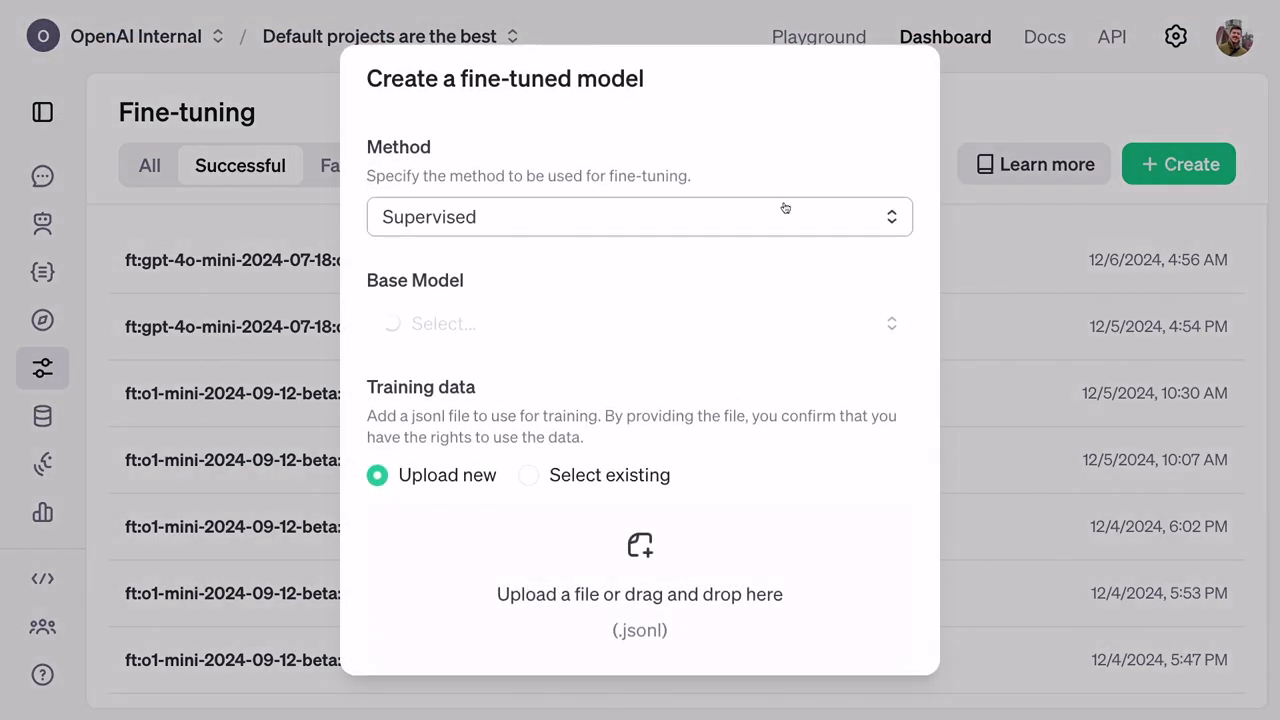

Đào tạo mô hình bắt đầu bằng việc tải lên các tập dữ liệu tùy chỉnh kết hợp với tiêu chí đánh giá (grader)

Fine-tuning tăng cường hoạt động thông qua một quy trình có cấu trúc:

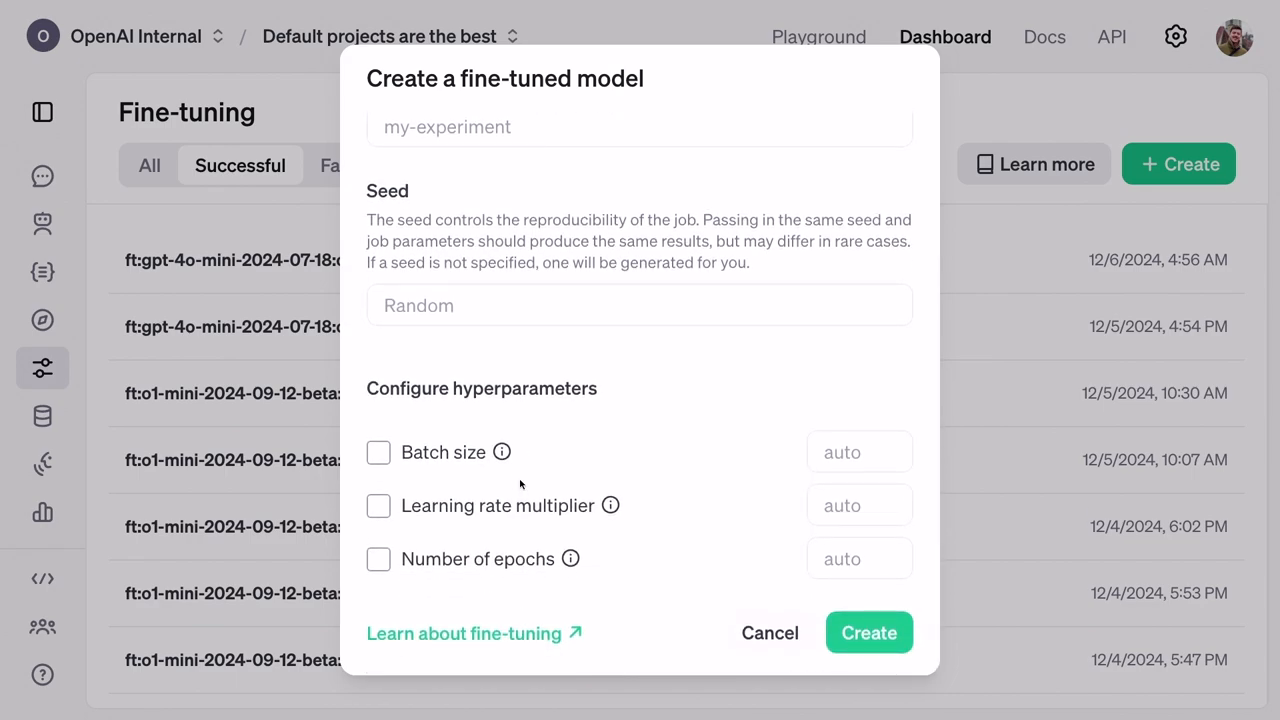

Chuẩn bị dữ liệu: Đào tạo yêu cầu các tệp JSONL chứa các ví dụ tùy chỉnh. Các tệp này bao gồm các đầu vào, hướng dẫn và câu trả lời nhưng ẩn kết quả thực tế trong quá trình đào tạo mô hình để tránh gian lận.

Đánh giá: Trong quá trình đào tạo, các mô hình cũng được đánh giá trên một tập dữ liệu xác nhận riêng để đảm bảo AI không chỉ ghi nhớ câu trả lời mà áp dụng suy luận thực sự.

Grader cho điểm số: Một khái niệm độc đáo trong RFT, "graders" là các tiêu chí đánh giá xác định điểm cho các dự đoán, thưởng cho các câu trả lời đúng trong khi không khuyến khích các mẫu sai.

Hạ tầng đào tạo: Hoạt động trên hệ thống đào tạo phân tán của OpenAI, fine-tuning tăng cường giúp các kỹ thuật tiên tiến trở nên dễ tiếp cận cho người dùng mà không cần sự chuyên môn kỹ thuật trực tiếp.

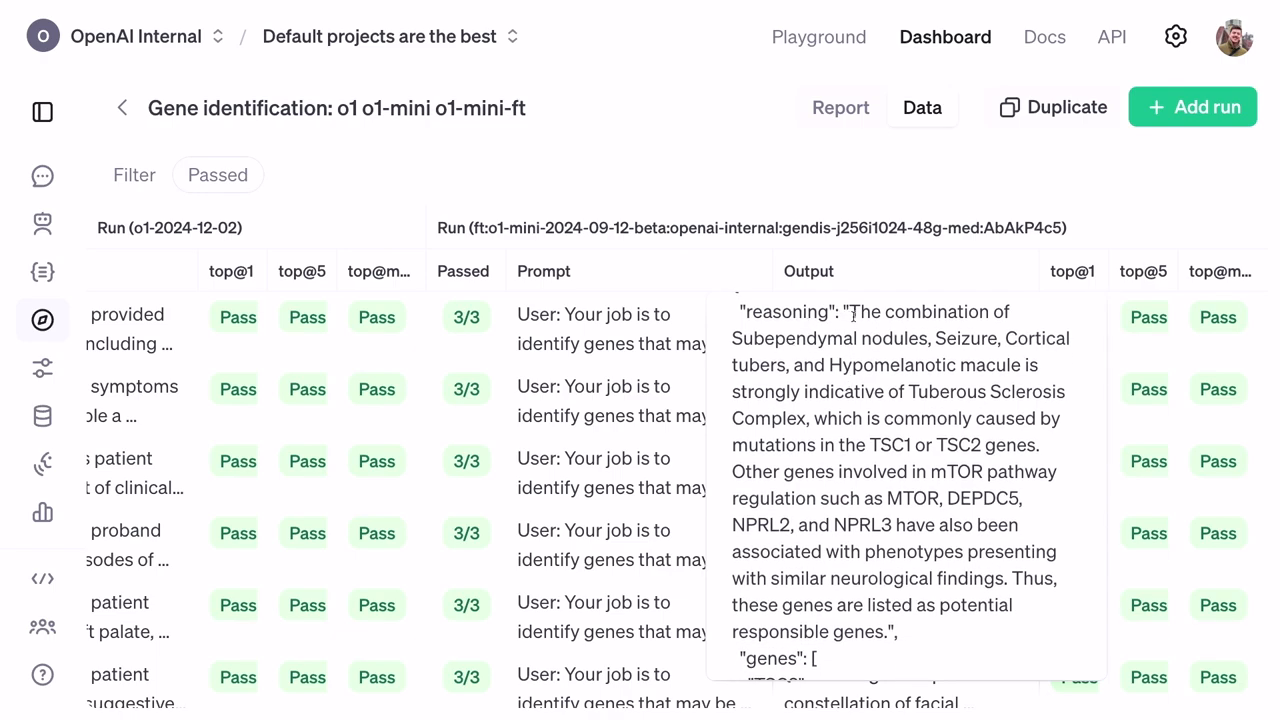

Đo lường hiệu suất: Các đánh giá sau đào tạo xem xét độ chính xác của mô hình đã cải thiện bằng cách phân tích các chỉ số thống kê như xếp hạng top-at-1 và top-at-5, cho thấy sự mạnh mẽ của mô hình đã được tinh chỉnh.

Fine-tuning cải thiện độ chính xác trong việc xác định các gen chịu trách nhiệm bằng cách sử dụng xếp hạng phân cấp.

Ý nghĩa thực tế: kết quả hiệu suất & suy luận

Các điểm số dựa trên xác thực cho thấy khả năng suy luận tinh vi hơn được mở khóa sau khi tinh chỉnh.

Với các mô hình đã được tinh chỉnh tăng cường của họ vượt trội hơn so với các cài đặt truyền thống, các kết quả đã chứng minh rằng ngay cả những mô hình nhỏ hơn và rẻ hơn cuối cùng có thể vượt qua các mức cơ bản tiêu tốn nhiều tài nguyên hơn. Sự cải thiện về độ chính xác đặc biệt thấy rõ trong xếp hạng của O1 Mini, đạt được khả năng suy luận tốt hơn và tỷ lệ thành công cao hơn đáng kể trong việc dự đoán các gen dựa trên triệu chứng.

Thêm vào đó, các kết quả khả thi bao gồm các lời giải thích cho các quyết định của AI, trao quyền cho các nhà nghiên cứu như Justin Reese khám phá các con đường suy luận chính xác—một tính năng quan trọng cho các chẩn đoán có tính sống còn.

Nhìn về phía trước: fine-tuning tăng cường cho các trường hợp sử dụng rộng hơn

OpenAI thông báo một chương trình nghiên cứu mở rộng để tận dụng fine-tuning tăng cường.

Tiềm năng của fine-tuning tăng cường vượt xa chăm sóc sức khỏe, khi OpenAI chứng minh tính linh hoạt của nó qua các ngành như sinh học thông tin, an toàn AI và hệ thống pháp lý. Trong khi đó, chương trình nghiên cứu Alpha mới được mở rộng của OpenAI mở ra cơ hội cho các trường đại học và doanh nghiệp thử nghiệm các mô hình đã được tinh chỉnh tăng cường trong các miền ngách của họ.

Sáng kiến này mời gọi những người lãnh đạo tham gia vào việc xử lý các nhiệm vụ phức tạp để thử nghiệm các giải pháp tiên tiến trước khi triển khai công khai, dự kiến sẽ diễn ra vào đầu năm 2024.

Kết luận: kết nối đổi mới với nhu cầu miền

Fine-tuning tăng cường mang lại tiềm năng vô hạn cho các ứng dụng AI theo nhiệm vụ

Fine-tuning tăng cường đánh dấu một bước tiến vĩ đại trong việc định hình cách AI tương tác với các nhiệm vụ chuyên biệt, từ sinh học đến tài chính. Bằng cách kết hợp suy luận logic với dữ liệu được điều chỉnh của chuyên gia, OpenAI mở đường cho các hệ thống AI có khả năng suy nghĩ một cách phản biện hơn, tổng quát một cách thông minh, và giải quyết các vấn đề khó khăn nhất của nhân loại.

Trong khi các ứng dụng của RFT vẫn đang phát triển, tác động hiện tại của nó dự đoán một tương lai mà các hệ thống AI thích ứng trở nên thiết yếu cho cả các lĩnh vực học thuật và công nghiệp. Lộ trình vẫn rõ ràng: kết hợp chuyên môn miền với cơ sở hạ tầng quy mô của OpenAI để tiên phong trong các giải pháp cho các biên giới công nghệ của ngày mai.