apache spark: a revolutionary tool for big data analytics and machine learning

在一个数据是新石油的世界中,处理和理解大量信息是技术进步的基石。Apache Spark已经成为处理大数据的最强大和高效的工具之一。这个开源数据分析引擎彻底改变了组织处理和分析大量数据流的方式。让我们深入探讨Apache Spark的概念,探索它的历史,与其他技术进行比较,并了解它如何像专家一样处理复杂的数据任务。

what is apache spark?

apache spark is a cutting-edge data analytics engine.

Apache Spark是一个开源数据分析引擎,旨在实时或批量处理来自多个来源的大量数据流。Spark处理如此复杂计算的能力就像“章鱼抛接链锯”。它专注于分布式数据处理,通过在内存中执行计算,达到了比传统基于磁盘的系统快100倍的速度。

the origins of apache spark

apache spark was created at uc berkeley's amp lab.

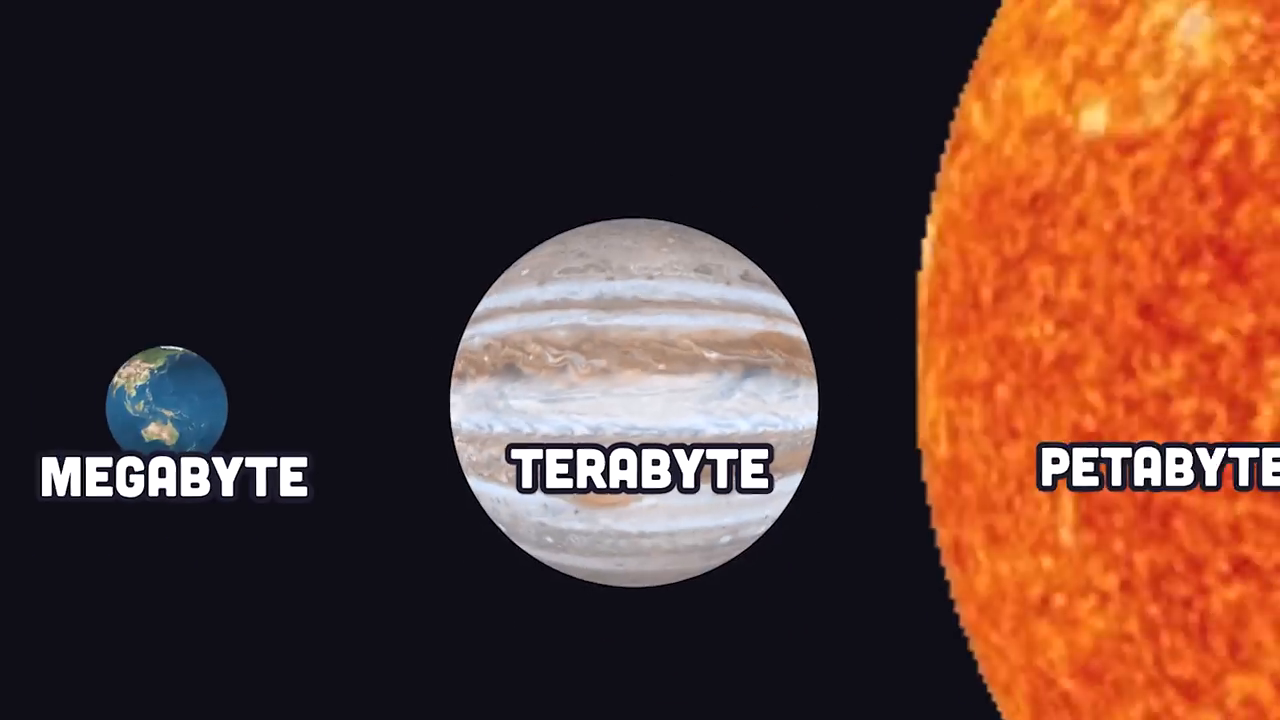

Apache Spark起源于2009年,由Matei Zaharia在加州大学伯克利分校的AMP实验室开发。在此期间,互联网上的数据生成经历了爆炸式增长,从兆字节到太字节。使用传统的单一机器对这种数据量进行分析几乎变得不可能。这种日益增长的需求催生了Apache Spark的开发,为研究人员和企业提供了一个能够跨分布式系统处理大量数据集的工具。

apache spark vs hadoop: the battle of big data tools

apache spark introduced in-memory data processing compared to hadoop's disk-based workflows.

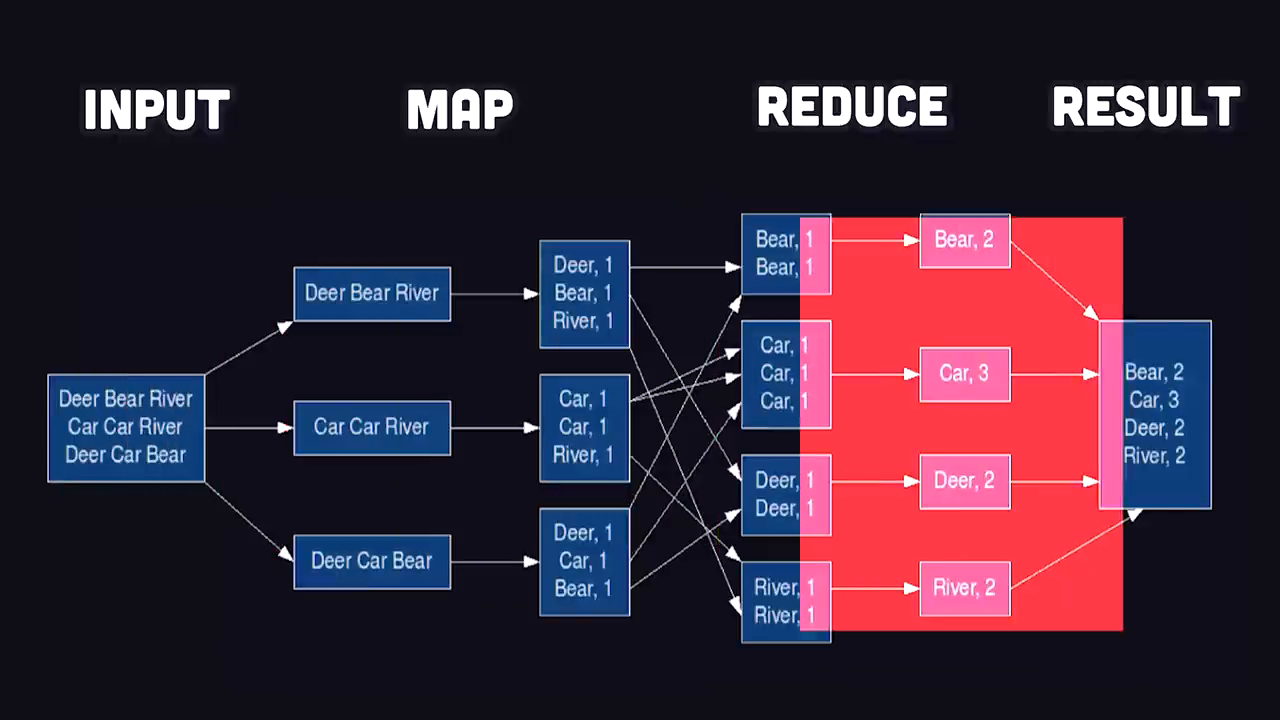

在Apache Spark出现之前,Hadoop的MapReduce是大数据分析的主导者。MapReduce采用了一种编程模型,将数据映射为键值对,通过洗牌、排序并减少成最终结果。尽管在处理分布式数据集方面高效,但MapReduce由于依赖于基于磁盘的输入/输出(I/O)操作而面临瓶颈。

Apache Spark通过引入内存数据处理方法改变了游戏规则。Spark不再将中间结果读写到磁盘,而是直接在RAM中处理数据,显著加快了计算速度。这一创新消除了I/O瓶颈,使Spark比其竞争对手快100倍。

real-world use cases of apache spark

apache spark powers data analytics for fortune 500 companies, nasa, and more.

Apache Spark为世界上一些最大的组织提供服务,涵盖多个行业:

- 亚马逊: Spark帮助分析电子商务数据,通过有针对性的推荐和预测改善客户体验。

- 美国宇航局喷气推动实验室: 它利用Spark处理大量空间数据,探索宇宙深处。

- 80%的财富500强公司: Spark已经成为企业处理复杂大数据管道和分析需求的首选解决方案。

尽管其声誉是分布式计算工具,Spark也可以在本地运行,使其对小型项目和个人开发者变得可及。

how apache spark works

getting started with apache spark

apache spark allows local and distributed processing via easy apis.

Apache Spark主要是用Java编写的,并运行在Java虚拟机(JVM)上。然而,它的API支持多种语言,如Python(通过PySpark)、SQL和Scala,从而使Spark对广泛的开发者基础更具可及性。要开始使用,您需要安装Spark并初始化一个会话。

solving real-world problems with spark

spark dataframe api enables intuitive real-world data filtering.

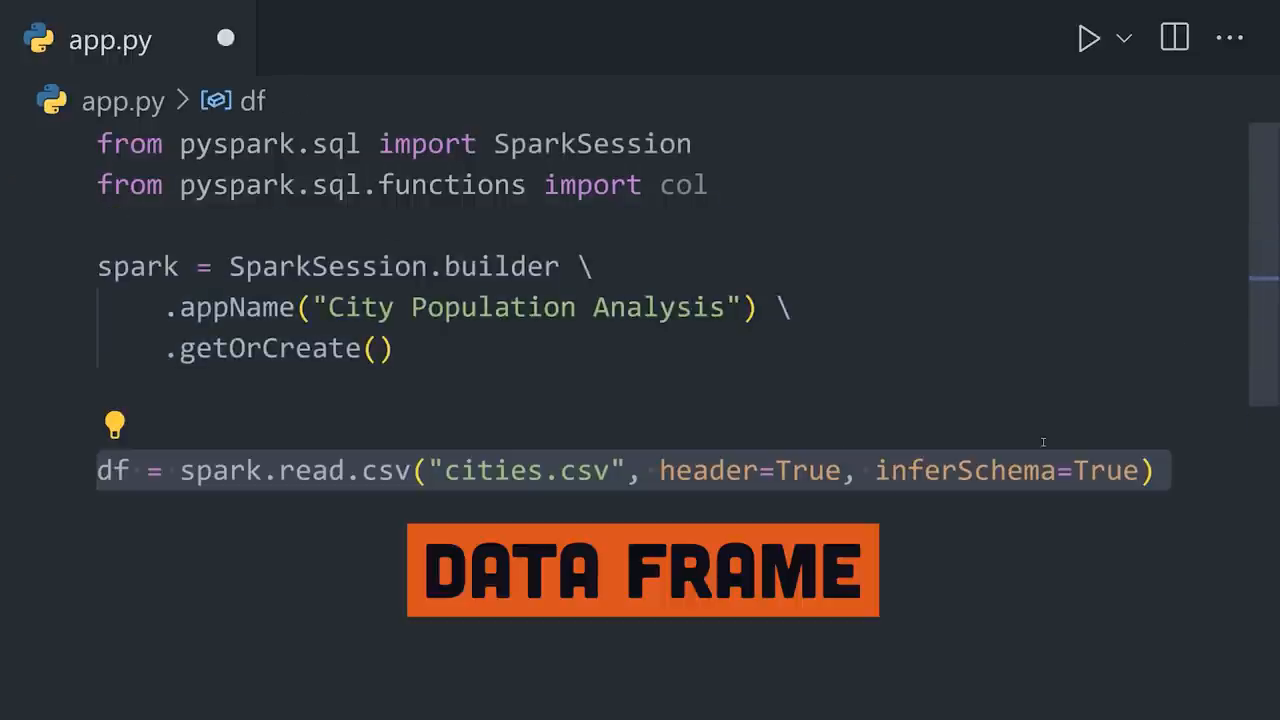

想象一下,您有一个包含城市数据的CSV文件,包括人口、纬度和经度。您的任务是找到位于热带之间的人口最多的城市。以下是Spark逐步处理该任务的方式:

- 将数据加载到内存中: Spark读取CSV文件,将其存储为数据框,将行和列转换为可以在分布式系统内存中处理的对象。

- 筛选数据: 使用Spark强大的转换函数排除热带以外的城市。

- 排序并选择结果: 按人口对筛选后的结果进行排序,并检索人口最多的城市。Spark通过其DataFrame API的链式方法使这一全过程无缝进行。

在这个例子中,Spark识别出墨西哥城是人口最多的热带城市。

spark with sql and distributed clusters

spark integrates with sql databases and supports clustered scaling.

对于使用SQL数据库的用户,Spark提供了简单的集成,可以直接查询数据,从而增强了其对数据库工程师的可用性。此外,在处理大规模数据集时,Spark的集群管理器或Kubernetes等容器编排工具可以水平扩展负载,在无与伦比的分布式处理方面达到最佳效果。

apache spark for machine learning at scale

spark's mllib simplifies large-scale machine learning.

Apache Spark在机器学习方面表现出色,其强大的库称为MLlib。通过将数据分布到集群,Spark可以轻松构建可扩展的机器学习管道。例如:

- 向量组装: MLlib允许开发者将多个列组合为单个向量列。

- 数据拆分: 为机器学习模型将数据拆分为训练和测试集。

- 算法选择: MLlib支持分类、回归、聚类等算法。

这种分布式训练确保模型能够利用Spark的大规模数据处理能力进行准确预测。

education and tools to get started with spark

skills in programming and analytics can unlock spark's full potential.

虽然Spark是一个强大的工具,但要发挥其全部潜力,需要扎实的编程、数据分析和解决问题的策略基础。像Brilliant.org这样的学习平台可以帮助个人通过沉浸式课程和实际练习来建立这些关键技能。投入时间提高逻辑思维和编程习惯可以显著增强您与Apache Spark等工具的熟练程度。

conclusion

apache spark unlocks the potential of scalable big data analytics.

Apache Spark继续通过其内存计算、可扩展性和与机器学习技术的集成来改变大数据分析。它已成为从学术研究到工业企业等多个领域的基石。无论您是在分析电子商务趋势、处理深空数据,还是在大规模训练机器学习模型,Spark都能提供无与伦比的性能和效率。

在我们站在像Apache Spark这样革命性工具的肩膀上时,持续学习和发展我们的技能以适应日益变化的技术格局是至关重要的。那么,为什么不今天就踏入Spark和大数据的世界呢?