使用 Gemini 2.0 和 Gemini 1.5 模型实现实时屏幕共享助手(带有语音和文本记录)

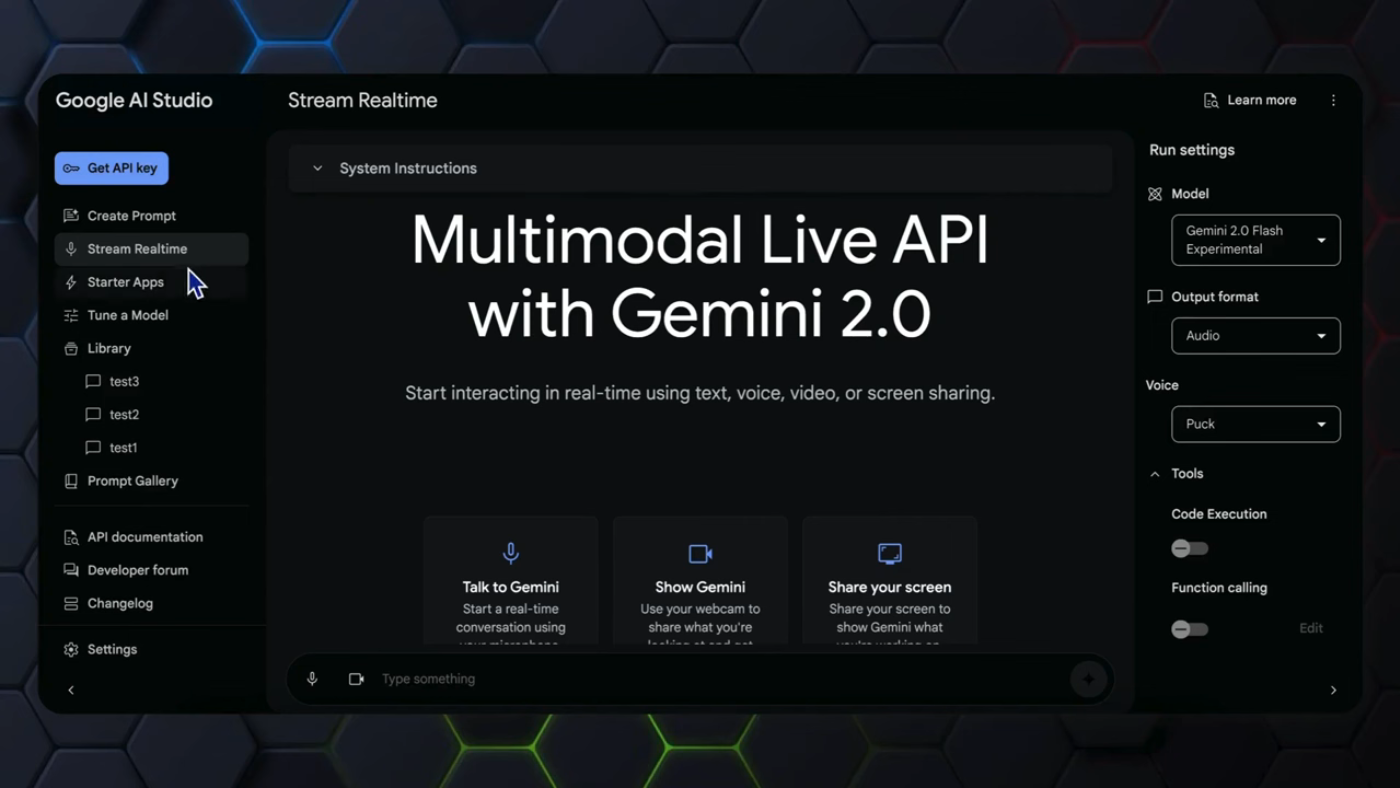

在本文中,我们将探讨如何使用 Gemini 2.0 和 Gemini 1.5 模型实现一个带有语音和文本记录的实时屏幕共享助手。Gemini 多模态实时 API 在之前的视频中已经用于展示其功能,包括通过文本、语音、摄像头和屏幕共享实现的实时交互。

介绍 Gemini 多模态实时 API

Gemini 多模态实时 API 是一个强大的工具,能够通过文本、语音、摄像头和屏幕共享实现实时交互。然而,仍然有一个关键问题阻碍了其在现实世界中的应用,即无法同时提供实时文本和音频响应。 介绍 Gemini 多模态实时 API

介绍 Gemini 多模态实时 API

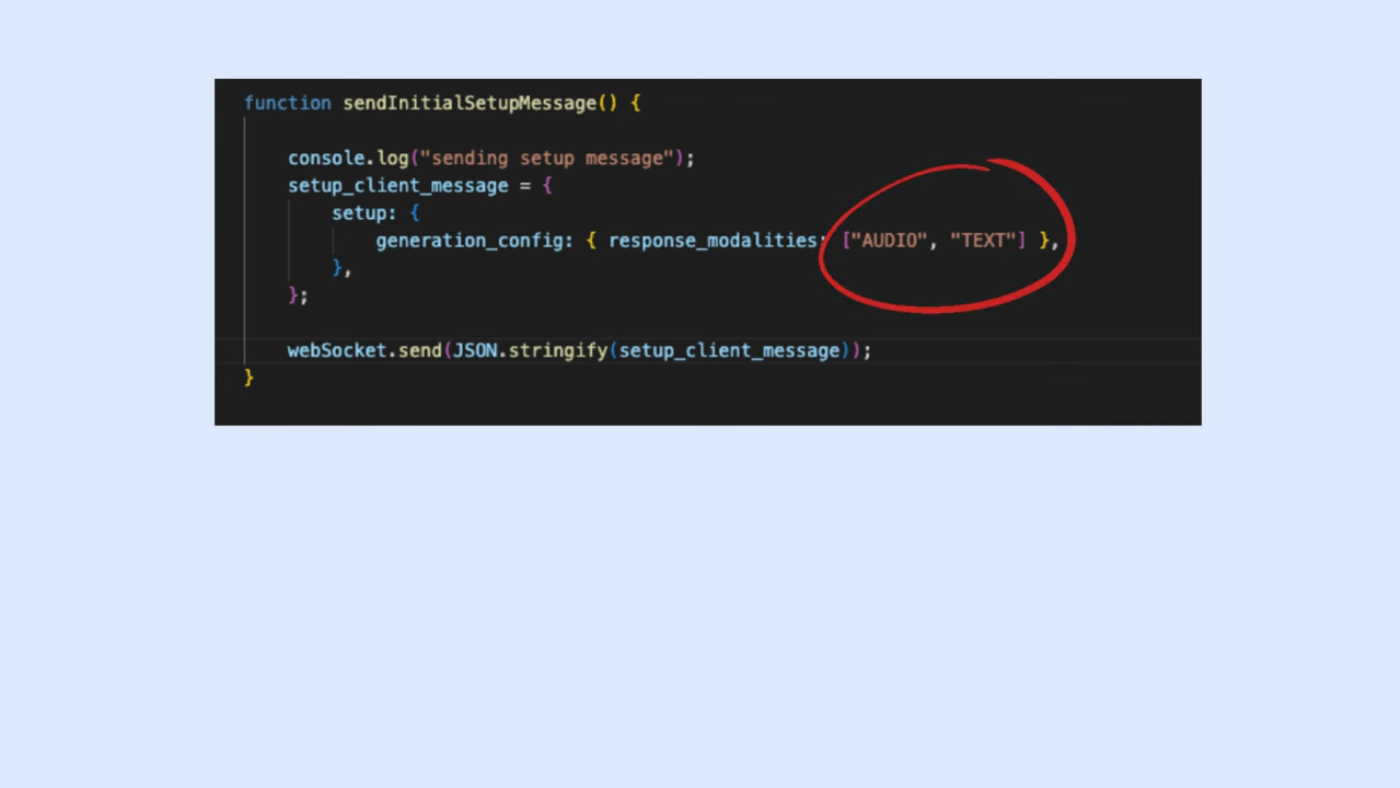

Gemini API 的剩余问题

库中的 "response_modality" 参数允许设置为 "audio" 加 "text" 的列表,但这个设置并没有按预期工作,反而只会报错。 Gemini API 的剩余问题

Gemini API 的剩余问题

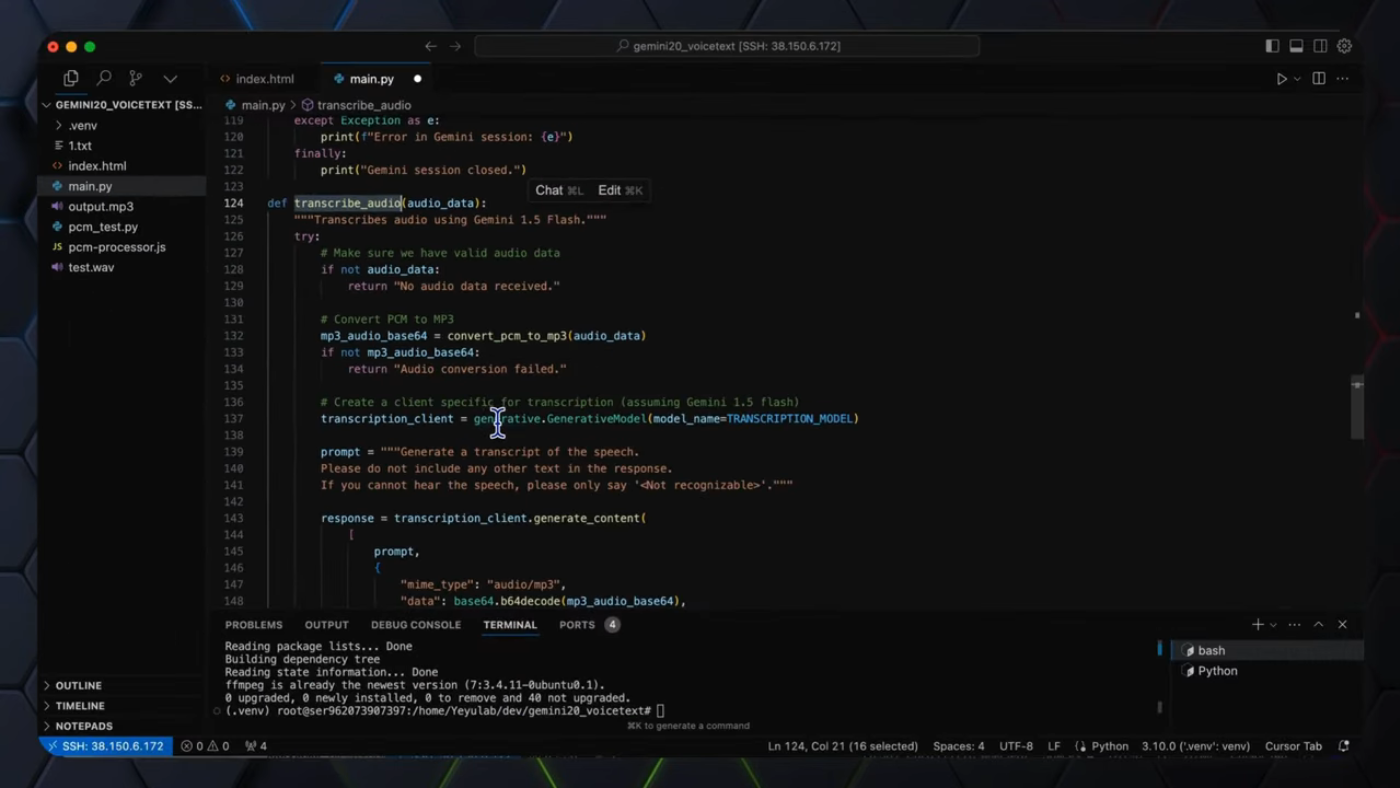

项目架构

该应用使用了两个 Gemini 模型来简化流程。首先,客户端将视觉和音频输入发送到服务器。然后,服务器使用 Gemini 2.0 Flash 模型生成实时音频流。接下来,服务器使用该输出,并通过 Gemini 1.5 Flash 8B 模型将其音频输出转录为文本。 项目架构

项目架构

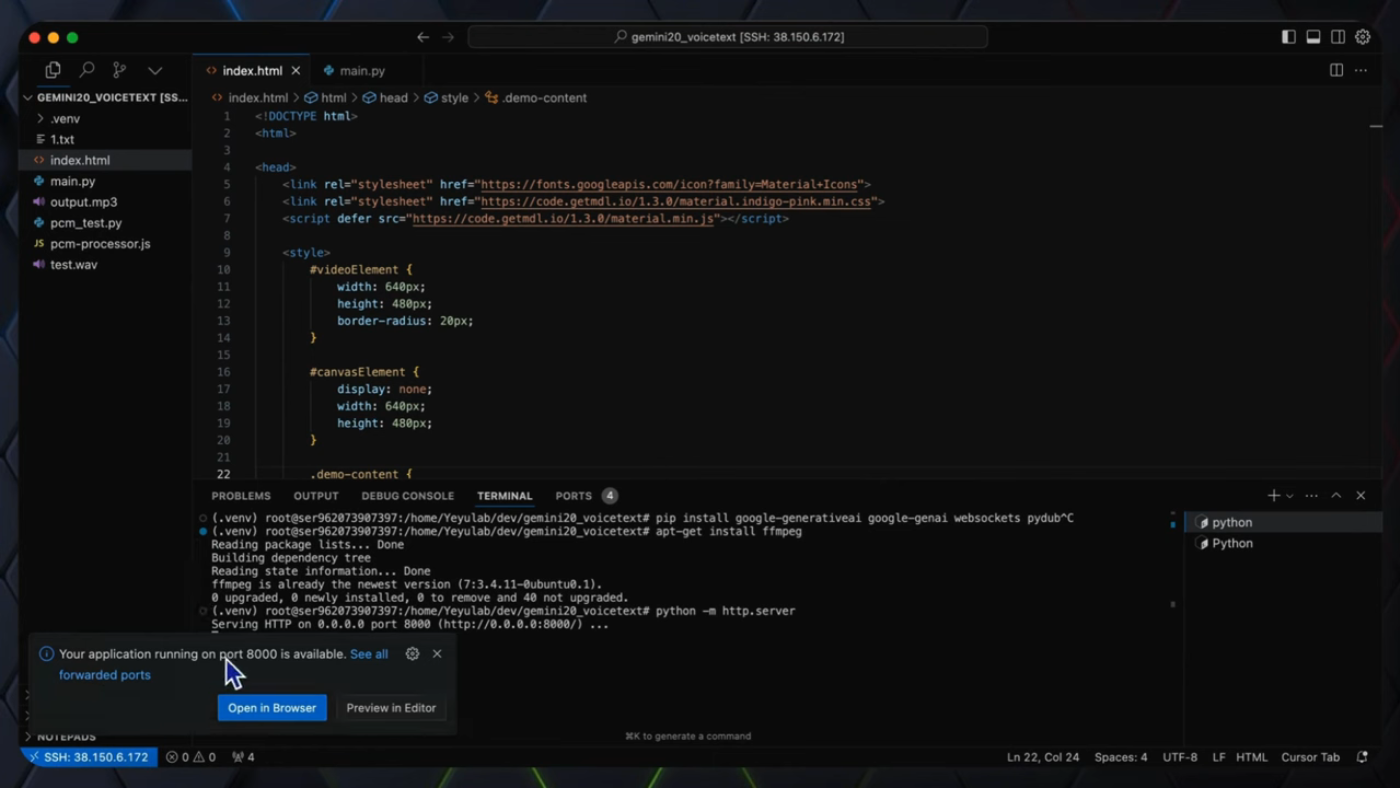

代码讲解

服务器代码负责处理客户端的配置消息,连接到 Gemini 2.0 多模态实时 API,并发送和接收数据。"gemini_session_handler" 函数用于处理与 Gemini 2.0 多模态实时 API 的 WebSocket 连接和数据交换。 代码讲解

代码讲解

运行应用

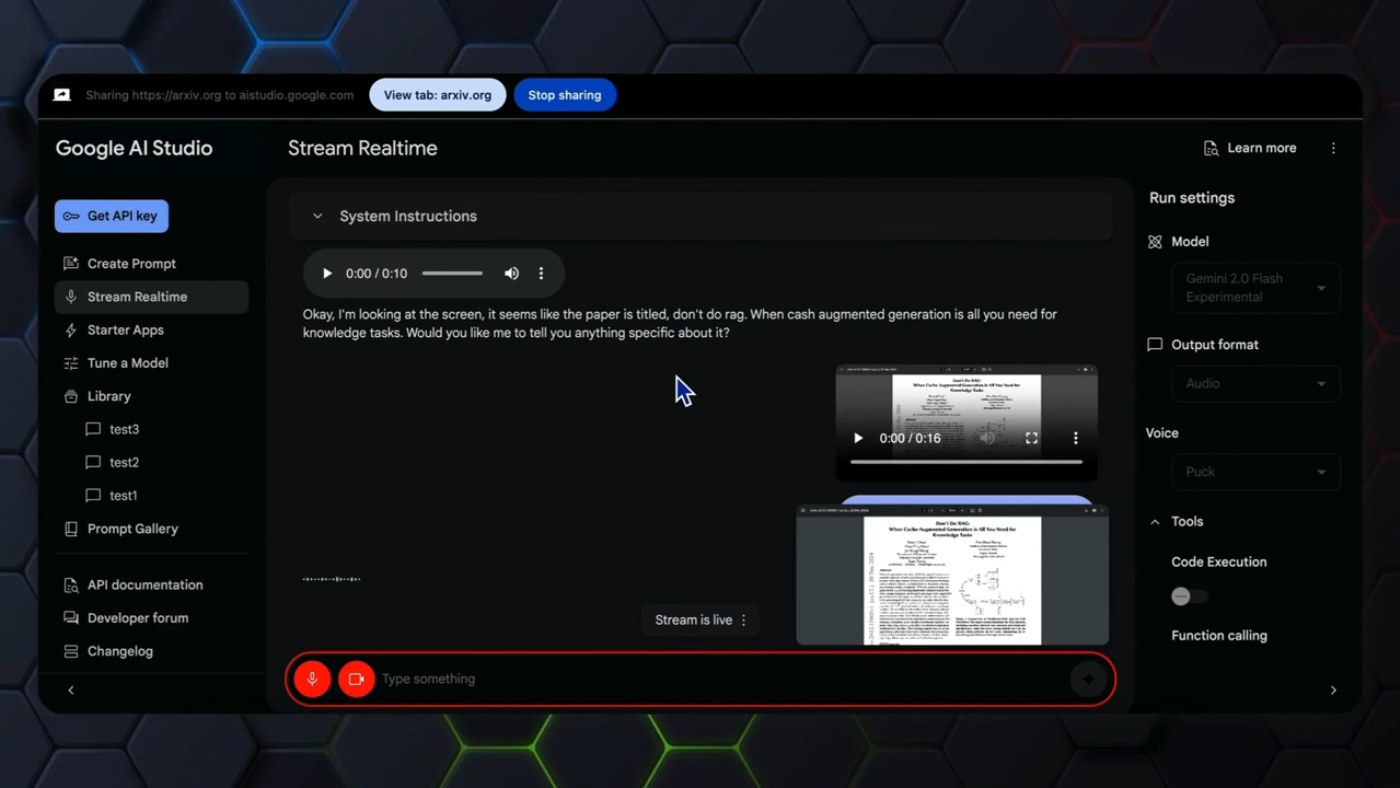

整个屏幕共享过程在上一个视频中已经用 Gemini 2.0 多模态实时 API 实现。文本和音频改进的关键功能在后端服务器中,前端代码可以从 GitHub 仓库中复制。 运行应用

运行应用

结论

总之,本视频通过提供可读的文本记录和音频反馈,解决了 Gemini 多模态实时 API 的局限性,以实现实时屏幕共享助手。该应用使用了两个 Gemini 模型来简化流程,服务器代码负责处理客户端的配置消息,连接到 Gemini 2.0 多模态实时 API,并发送和接收数据。 结论

结论

未来发展

Gemini 多模态实时 API 仍处于早期阶段,未来有很多发展的机会。使用两个不同的模型,Gemini 2.0 Flash 和 Gemini 1.5 Flash 8B,为实时音频流生成和转录提供了一种高效且经济的解决方案。 未来发展

未来发展