强化微调的曙光:开启人工智能多样性的下一个前沿

强化微调(RFT)首次亮相,成为人工智能模型定制方面最重要的进展之一。最近在OpenAI的演示中展示了这种先进的方法,承诺将彻底改变开发者、研究人员和企业优化其人工智能模型以应对特定任务的方式。由OpenAI团队主导的这场演示揭示了将强化学习技术与可定制微调相结合的力量,这一飞跃使得前沿人工智能模型,如GPT-4和O1系列,变得比以往更加适应。

本文深入探讨了演示的文稿中的见解,分析了强化微调的原因、内容和方法,以及其实际应用。

OpenAI最新的创新:O1和强化微调

OpenAI的首席研究员Mark在会议开始时介绍了他们最新的模型系列O1。该系列模型最近推出,在解决问题的方法上实现了重大飞跃;这些模型在生成响应之前会“思考”一段时间,代表了一种更细致的决策过程。

强化微调基于这一创新,通过使开发者和组织能够使用他们的自定义数据集来调整O1模型——不是通过传统的微调,而是通过强化学习原理。

这一进展不仅仅是模仿现有输入;相反,它使模型能够更系统地推理。正如Mark所解释的,给予模型“思考空间”的方法优化推理管道、增强泛化,并使用户能够创建特定领域的专家模型。

为什么强化微调很重要

对人工智能模型进行微调的能力潜力巨大,尤其对于处理专业数据的组织而言。强化微调的独特之处在于,它使得开发超越模式匹配的人工智能工具成为可能;它允许在数据上进行逻辑推理。OpenAI强调了几个关键领域,其中O1强化微调过程提供了变革性的应用案例:

- 法律与金融: 为依赖逻辑驱动分析的行业开发领域特定工具。

- 工程与保险: 优化针对结构化和系统化思考过程的任务特定推理。

- 医疗与生物学: 支持研究人员在遗传分析和药物开发等领域的工作。

例如,OpenAI最近与汤森路透的合作,利用强化微调增强了Co-Counsel AI,这是一种能够处理复杂法律研究任务的法律助手。

这些示例强调了RFT通过利用强化学习奖赏正确推理的能力来解锁新的效率。

监督微调与强化微调的区别

监督微调反映风格或语调,而RFT教人工智能以新方式进行逻辑推理

在2022年,OpenAI向其API工具包介绍了监督微调。虽然其本身也很强大,但监督微调侧重于教人工智能复制输入数据中的特征——这对改变语气、风格或格式很有用,但不太适合解决基于推理的挑战。

相对而言,强化微调强调教模型推理和解决问题。具体如下:

- 批判性思考空间: RFT使人工智能模型能够暂停、评估问题,并基于证据生成逻辑解决方案。

- 反馈驱动学习: 正确的推理路径获得奖励,而错误的推理受到惩罚。这种反馈引导模型朝着更高的能力发展。

- 跨领域的泛化能力: 通过分析仅限数据集中的少数几个示例,使用RFT训练的模型学会在特定领域更好地推理。

例如,正如演示中讨论的,通过使用生物医学数据对模型进行指导,在接触到仅几十个训练示例后,显著提升了性能。

科学应用:用强化微调探索遗传学

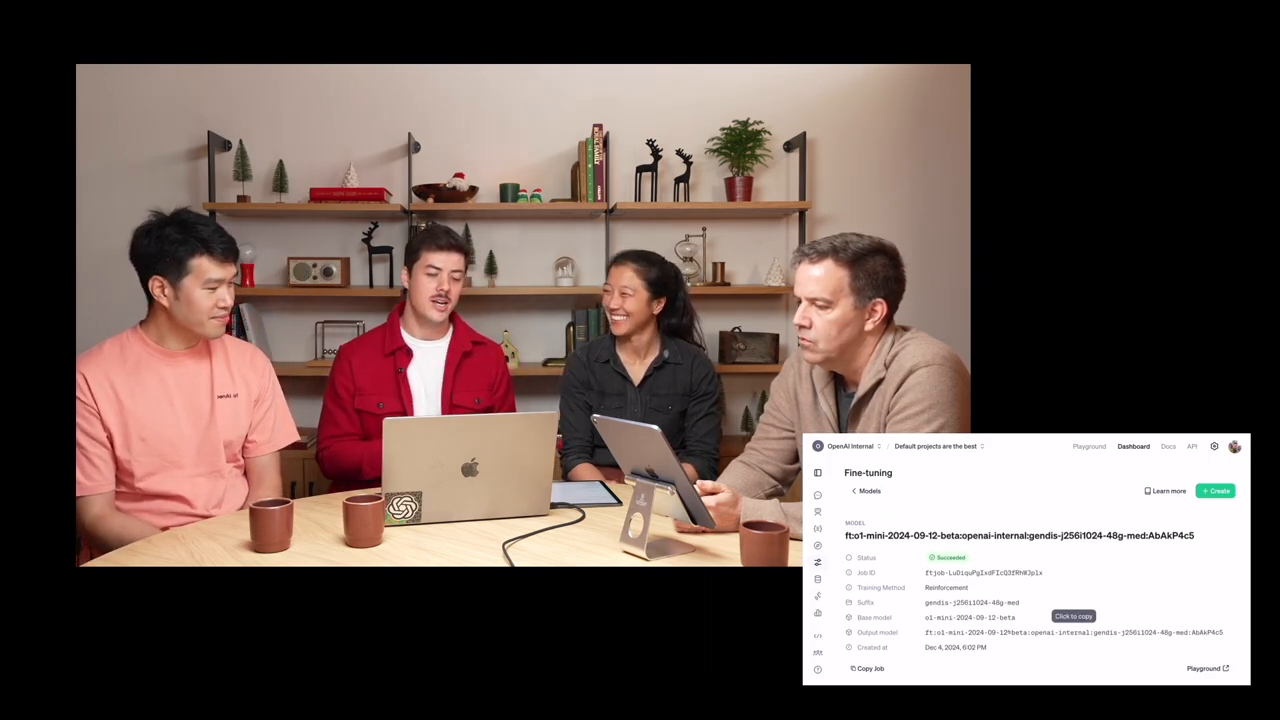

强化微调当前应用于的最令人兴奋的领域之一是科学研究。伯克利实验室的计算生物学家Justin Reese分享了他利用OpenAI的模型探索罕见遗传疾病的经验。

罕见疾病单独来看可能显得不常见,但集体影响着全球超过三亿人。由于所需的专业知识,诊断这些疾病通常需要数月或数年的时间。通过将强化微调与以下数据集结合:

- 医疗病例报告

- 症状列表(包括存在和缺失的症状)

- 导致特定疾病的遗传标记

Justin和他的团队制作了一种能够系统性推理遗传突变的人工智能模型,从而加快研究工作流程,提高诊断准确性。

这一跨学科合作——涵盖伯克利实验室、德国查理特医院和全球医疗计划——体现了RFT的变革潜力。

逐步解析:强化微调的工作原理

强化微调通过结构化过程展开:

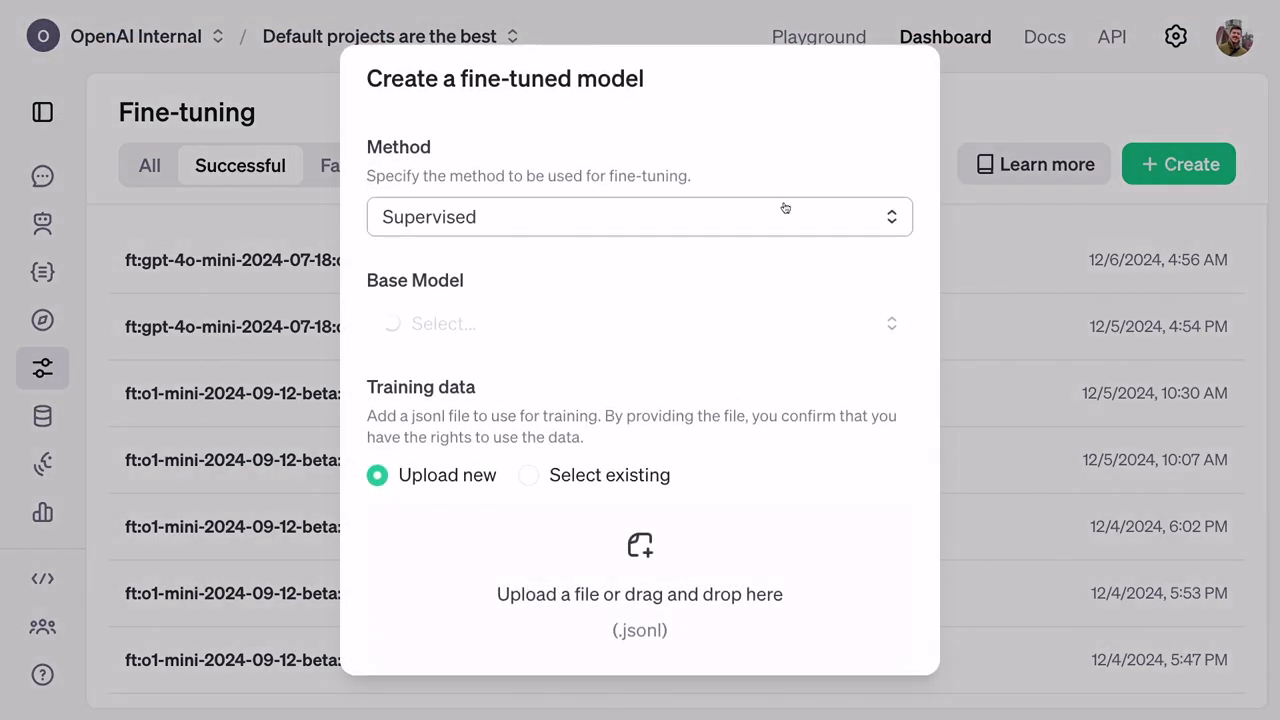

数据集准备: 训练需要包含自定义示例的JSONL文件。这些示例包括输入、指令和答案,但在模型训练期间隐藏实际结果,以避免作弊。

验证: 在训练过程中,模型还在单独的验证数据集上进行评估,以确保AI不会仅仅记忆答案,而是应用真正的推理。

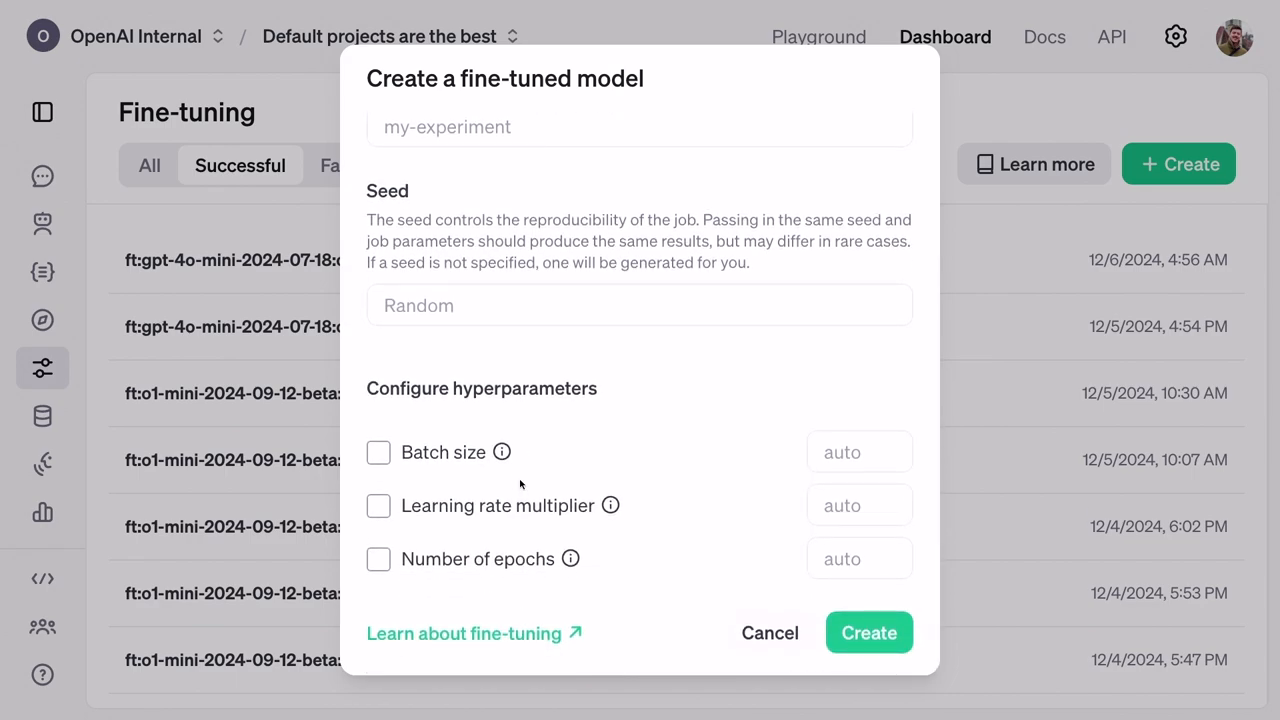

评分者: RFT中的一个独特概念是“评分者”,它是分配分数给预测结果的评估指标,奖励正确答案,同时抑制错误模式。

训练基础设施: 在OpenAI的分布式训练系统上运行,强化微调为用户提供了尖端技术,而无需直接的工程专业知识。

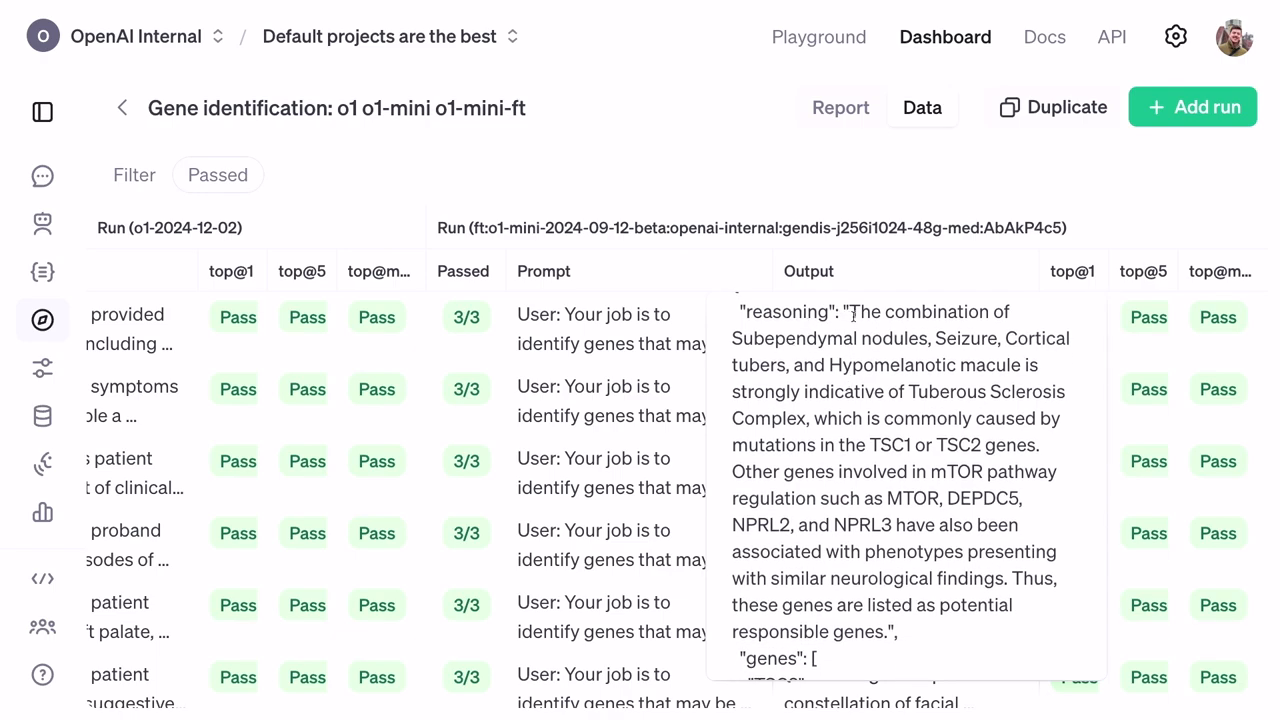

性能测量: 训练后的评估通过分析统计指标(如top-at-1和top-at-5排名)来评估改进后的模型准确性,展示微调模型的鲁棒性。

现实世界影响:性能结果与推理

通过强化微调的模型超越传统设置,结果展示了即使是更小、更便宜的模型最终也能超越资源密集型的基准。准确性提升在O1 Mini的排名中尤为明显,其在基于症状预测基因方面获得了更好的推理和显著更高的成功率。

此外,行动结果包括对人工智能决策的解释,让像Justin Reese这样的科研人员探究确切的推理路径——这一特征对生命关键诊断至关重要。

展望未来:强化微调的更广泛应用

强化微调的潜力远不止于医疗,OpenAI展示了它在生物信息学、人工智能安全和法律系统等领域的灵活性。同时,OpenAI新扩展的Alpha研究计划为大学和企业在其专业领域内尝试强化微调模型提供了机会。

该计划邀请参与处理复杂任务的领导者在公开奖励前测试前沿解决方案,预计将在2024年初推广。

结论:将创新与领域需求连接起来

强化微调标志着塑造人工智能如何与专业任务互动的重大飞跃,从生物学到金融。通过将逻辑推理与专业定制数据相结合,OpenAI为能够更具批判性地思考、智能地泛化和解决人类最棘手问题的人工智能系统铺平了道路。

尽管RFT的应用仍在不断演变,但其当前影响预示着未来可调适的人工智能系统将成为学术界和工业界不可或缺的一部分。路线图依然明确:将领域专业知识与OpenAI的可扩展基础设施结合,以开创明天技术前沿的解决方案。